Narzędzia użytkownika

Narzędzia witryny

Jesteś tutaj: PQStat - Baza Wiedzy » PQStat - Baza Wiedzy » statpqpl » Porównanie - więcej niż 2 grupy

Pasek boczny

pl:statpqpl:porown3grpl

Spis treści

Porównanie - więcej niż 2 grupy

{\ovalnode{A}{\hyperlink{rozkład_normalny}{\begin{tabular}{c}Czy rozkład\\zmiennych jest\\rozkładem\\normalnym?\end{tabular}}}}

\rput[tl](0.15,10){\ovalnode{B}{\hyperlink{zalezne_niezalezne}{\begin{tabular}{c}Czy zmienne\\są powiązane?\end{tabular}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{A}{B}

\rput[tl](4.5,9.8){\ovalnode{M}{\hyperlink{sferycznosc}{\begin{tabular}{c}Czy\\sferyczność\\jest spełniona?\end{tabular}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{B}{M}

\rput[br](10.9,8){\rnode{P}{\psframebox{\hyperlink{anovar}{\begin{tabular}{c}ANOVA\\dla grup\\zależnych\end{tabular}}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{M}{P}

\rput[br](7.7,5.5){\rnode{R}{\psframebox{\hyperlink{kor_br_sf}{\begin{tabular}{c}MANOVA\\lub ANOVA\\z korekta\\Epsilon, GG, H-F\end{tabular}}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{M}{R}

\rput[tl](0.1,8){\ovalnode{C}{\hyperlink{wariancja}{\begin{tabular}{c}Czy wariancje\\zmiennych\\w populacjach\\ są równe?\end{tabular}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{B}{C}

\rput[br](3,3){\rnode{D}{\psframebox{\hyperlink{anova_one_way}{\begin{tabular}{c}ANOVA\\dla grup\\niezależnych\end{tabular}}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{C}{D}

\rput[br](7.75,3.4){\rnode{N}{\psframebox{\hyperlink{anova_one_way_cor}{\begin{tabular}{c}ANOVA\\dla grup\\niezależnych\\z korekta $F^*$ i $F''$\end{tabular}}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{C}{N}

\psline{->}(3.7,12.3)(6,12.3)

\rput(2.2,10.4){T}

\rput(2.2,8.3){N}

\rput(2.2,5.0){T}

\rput(4.8,12.5){N}

\rput(6.8,11.4){T}

\rput(8.9,11.4){N}

\rput(11.9,11.4){T}

\rput(14.1,11.4){N}

\rput(4.2,9.5){T}

\rput(4.1,6.1){N}

\rput(8.5,9.1){T}

\rput(6.5,7.7){N}

\rput(8,14){Skala porządkowa}

\rput[tl](6,13){\ovalnode{E}{\hyperlink{zalezne_niezalezne}{\begin{tabular}{c}Czy zmienne\\są powiązane?\end{tabular}}}}

\rput[br](7.8,10){\rnode{F}{\psframebox{\hyperlink{anova_friedmana}{\begin{tabular}{c}ANOVA\\Friedmana\end{tabular}}}}}

\rput[br](10.0,9.6){\rnode{G}{\psframebox{\hyperlink{anova_kruskal-wallis}{\begin{tabular}{c}ANOVA\\Kruskala\\Wallisa\end{tabular}}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{E}{F}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{E}{G}

\rput(13,14){Skala nominalna}

\rput[tl](11,13){\ovalnode{H}{\hyperlink{zalezne_niezalezne}{\begin{tabular}{c}Czy zmienne\\są powiązane?\end{tabular}}}}

\rput[br](13.1,10){\rnode{I}{\psframebox{\hyperlink{anova_q_cochrana}{\begin{tabular}{c}ANOVA\\Q-Cochrana\end{tabular}}}}}

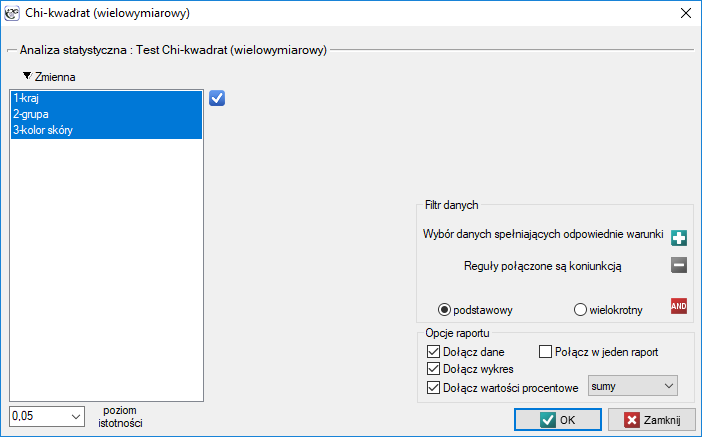

\rput[br](16.1,8.41){\rnode{J}{\psframebox{\hyperlink{chi_kwadrat_olbrzymi}{\begin{tabular}{c}test $\chi^2$ dla\\ wielowymiarowych\\tabel kontngencji\end{tabular}}}}}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{H}{I}

\ncline[angleA=-90, angleB=90, arm=.5, linearc=.2]{->}{H}{J}

\rput(3.5,4.9){\hyperlink{test_levenea}{test Levenea,}}

\rput(3.5,4.6){\hyperlink{test_levenea}{Browna-Forsythea}}

\psline[linestyle=dotted]{<-}(2.6,5.6)(3.5,5.0)

\rput(4,11){\hyperlink{testy_normalnosci}{testy normalnosci}}

\rput(4,10.7){\hyperlink{testy_normalnosci}{rozkladu}}

\psline[linestyle=dotted]{<-}(3.2,11.4)(3.9,11.2)

\rput(9.0,7.0){\hyperlink{sferycznosc}{test Mauchlya}}

\psline[linestyle=dotted]{<-}(7.9,8.1)(9.0,7.3)

\end{pspicture}

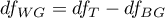

\end{center}}](/lib/exe/fetch.php?media=wiki:latex:/img8fc22227a9b4db11a09e29c0770afd70.png)

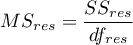

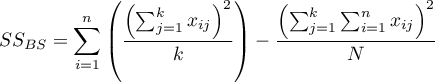

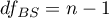

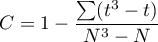

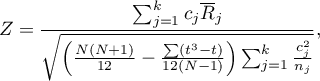

Uwaga!

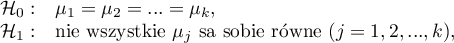

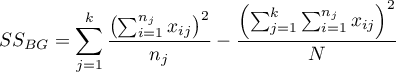

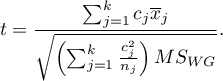

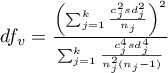

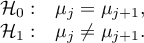

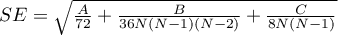

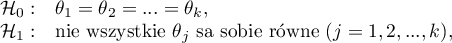

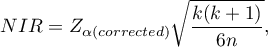

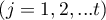

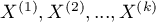

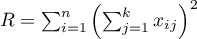

Zaproponowany schemat wyboru testów do porównania wielu grup nie jest jedynym możliwym schematem i nie zawiera wszystkich zaproponowanych w programie testów przeznaczonych do tego porównania.

Uwaga!

Jednoczesne porównywanie większej liczby grup NIE może być zastąpione wielokrotnym wykonywaniem testów dla porównania dwóch grup. Wynika to z konieczności kontrolowania błędu pierwszego rodzaju  . Wybierając poziom

. Wybierając poziom  i stosując

i stosując  -krotnie wybrany test dla porównania dwóch grup zwiększylibyśmy znacznie założony poziom

-krotnie wybrany test dla porównania dwóch grup zwiększylibyśmy znacznie założony poziom  . Tego błędu unikniemy stosując odpowiednie testy ANOVA (ang. Analysis of Variance) oraz dedykowane im kontrasty, czy też testy POST-HOC.

. Tego błędu unikniemy stosując odpowiednie testy ANOVA (ang. Analysis of Variance) oraz dedykowane im kontrasty, czy też testy POST-HOC.

Testy parametryczne

ANOVA dla grup niezależnych

Jednoczynnikowa analiza wariancji (ANOVA) dla grup niezależnych (ang. one-way analysis of variance) zaproponowana przez Ronalda Fishera, służy do weryfikacji hipotezy o równości średnich badanej zmiennej w kilku (

Jednoczynnikowa analiza wariancji (ANOVA) dla grup niezależnych (ang. one-way analysis of variance) zaproponowana przez Ronalda Fishera, służy do weryfikacji hipotezy o równości średnich badanej zmiennej w kilku ( ) populacjach.

) populacjach.

Podstawowe warunki stosowania:

- pomiar na skali interwałowej,

- normalność rozkładu badanej zmiennej w każdej populacji,

- równość wariancji badanej zmiennej wszystkich populacji.

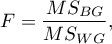

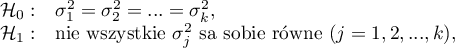

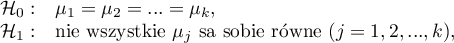

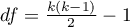

Hipotezy:

gdzie:

,

, ,…,

,…,

średnie badanej zmiennej w populacjach, z których pobrano próby.

średnie badanej zmiennej w populacjach, z których pobrano próby.

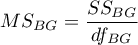

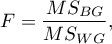

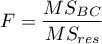

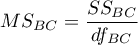

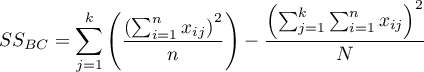

Statystyka testowa ma postać:

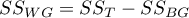

gdzie:

- średnia kwadratów między grupami,

- średnia kwadratów między grupami,

- średnia kwadratów wewnątrz grup,

- średnia kwadratów wewnątrz grup,

- suma kwadratów między grupami,

- suma kwadratów między grupami,

- suma kwadratów wewnątrz grup,

- suma kwadratów wewnątrz grup,

- całkowita suma kwadratów,

- całkowita suma kwadratów,

- stopnie swobody (między grupami),

- stopnie swobody (między grupami),

- stopnie swobody (wewnątrz grup),

- stopnie swobody (wewnątrz grup),

- całkowite stopnie swobody,

- całkowite stopnie swobody,

,

,

- liczności prób dla

- liczności prób dla  ,

,

- wartości zmiennej w próbach dla

- wartości zmiennej w próbach dla  ,

,  .

.

Statystyka ta podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Wielkość efektu - cząstkowa

Wielkość ta określa proporcję wariancji wyjaśnionej do wariancji całkowitej związanej z danym czynnikiem. Zatem w modelu jednoczynnikowej ANOVA dla grup niezależnych wskazuje jaka część wewnątrzosobowej zmienności wyników może być przypisana badanemu czynnikowi wyznaczającemu grupy niezależne.

Testy POST-HOC

Wprowadzenie do kontrastów i testów POST-HOC

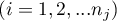

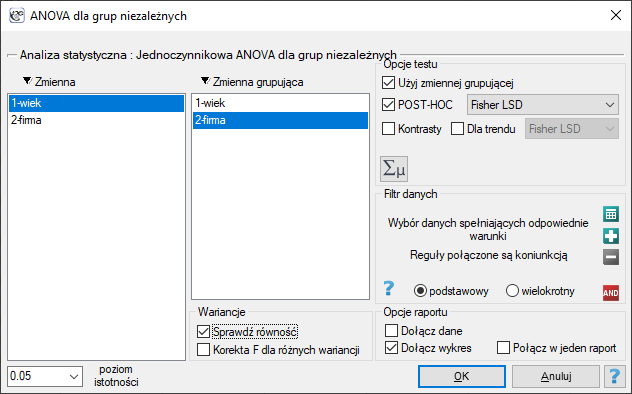

Okno z ustawieniami opcji jednoczynnikowej ANOVA dla grup niezależnych wywołujemy poprzez menu Statystyka→Testy parametryczne→ANOVA dla grup niezależnych lub poprzez Kreator.

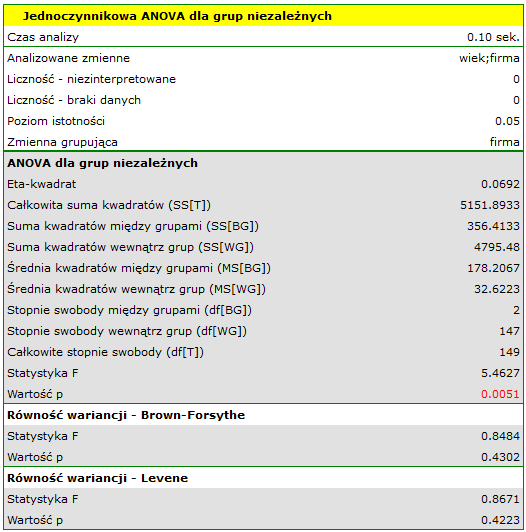

Przykład (plik wiek ANOVA.pqs)

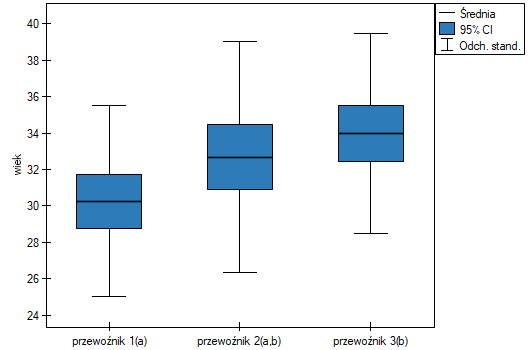

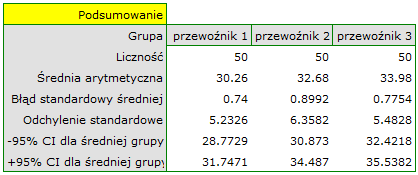

W pewnym doświadczeniu bierze udział 150 osób wybranych w sposób losowy z populacji pracowników 3 różnych firm przewozowych. Z każdej firmy do próby wybrano 50 osób. Przed przystąpieniem do eksperymentu należy sprawdzić czy średni wiek pracowników tych firm jest podobny, od tego bowiem zależeć będzie kolejny etap eksperymentu. Wiek każdego uczestnika eksperymentu zapisano w latach.

Wiek (przewoźnik 1): 27, 33, 25, 32, 34, 38, 31, 34, 20, 30, 30, 27, 34, 32, 33, 25, 40, 35, 29, 20, 18, 28, 26, 22, 24, 24, 25, 28, 32, 32, 33, 32, 34, 27, 34, 27, 35, 28, 35, 34, 28, 29, 38, 26, 36, 31, 25, 35, 41, 37

Wiek (przewoźnik 2): 38, 34, 33, 27, 36, 20, 37, 40, 27, 26, 40, 44, 36, 32, 26, 34, 27, 31, 36, 36, 25, 40, 27, 30, 36, 29, 32, 41, 49, 24, 36, 38, 18, 33, 30, 28, 27, 26, 42, 34, 24, 32, 36, 30, 37, 34, 33, 30, 44, 29

Wiek (przewoźnik 3): 34, 36, 31, 37, 45, 39, 36, 34, 39, 27, 35, 33, 36, 28, 38, 25, 29, 26, 45, 28, 27, 32, 33, 30, 39, 40, 36, 33, 28, 32, 36, 39, 32, 39, 37, 35, 44, 34, 21, 42, 40, 32, 30, 23, 32, 34, 27, 39, 37, 35

Przed przystąpieniem do analizy ANOVA potwierdzono normalność rozkładu danych.

W oknie analizy sprawdzono założenie równości wariancji, uzyskując w obydwu testach p>0.05.

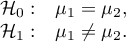

Hipotezy:

Porównując wartość  jednoczynnikowej analizy wariancji z poziomem istotności

jednoczynnikowej analizy wariancji z poziomem istotności  stwierdzamy, że średni wiek pracowników tych firm przewozowych jest różny. Na podstawie wyniku samej ANOVA nie możemy odpowiedzieć sobie na pytanie, które grupy różnią się pod względem wieku. By uzyskać taką wiedzę wykorzystany zostanie jeden z testów POST-HOC, np. test Tukeya. W tym celu {wznawiamy analizę} przyciskiem

stwierdzamy, że średni wiek pracowników tych firm przewozowych jest różny. Na podstawie wyniku samej ANOVA nie możemy odpowiedzieć sobie na pytanie, które grupy różnią się pod względem wieku. By uzyskać taką wiedzę wykorzystany zostanie jeden z testów POST-HOC, np. test Tukeya. W tym celu {wznawiamy analizę} przyciskiem  i w oknie opcji testu wybieramy

i w oknie opcji testu wybieramy Tukey HSD oraz dołączmy wykres.

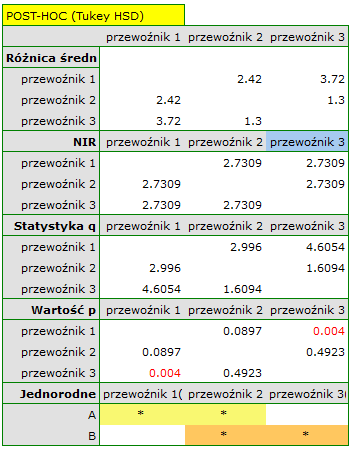

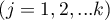

Najmniejsza istotna różnica (NIR) wyznaczona dla każdej pary porównań jest taka sama (ponieważ liczności grup są sobie równe) i wynosi 2.7309. Porównanie wartości NIR z wartością różnicy średnich wskazuje, że istotne różnice występują tylko pomiędzy wartością średnią dla wieku pracowników pierwszej i trzeciej firmy przewozowej (tylko w przypadku porównania tych dwóch grup wartość NIR jest mniejsza od różnicy średnich). Ten sam wniosek wyciągniemy porównując wartości  testu POST-HOC z poziomem istotności

testu POST-HOC z poziomem istotności  . Pracownicy pierwszej firmy są młodsi średnio o nieco ponad 3 lata od pracowników trzeciej firmy. Uzyskano dwie, zazębiające się grupy jednorodne, które zaznaczono również na wykresie.

. Pracownicy pierwszej firmy są młodsi średnio o nieco ponad 3 lata od pracowników trzeciej firmy. Uzyskano dwie, zazębiające się grupy jednorodne, które zaznaczono również na wykresie.

Dokładny opis danych możemy przedstawić wybierając w oknie analizy statystyki opisowe

2014/08/22 20:00

Kontrasty i testy POST-HOC

Analiza wariancji daje informację tylko o tym, czy między populacjami występują istotne statystycznie różnice. Nie mówi ona, które populacje różnią się między sobą. By uzyskać wiedzę o różnicach dla fragmentu naszego złożonego układu stosujemy kontrasty (gdy dokonujemy wcześniej zaplanowanych i zwykle tylko wybranych porównań - tzw. a'priori), lub procedury porównań wielokrotnych czyli testy POST-HOC (gdy po wykonanej analizie wariancji szukamy różnic, zwykle pomiędzy wszystkimi parami).

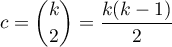

Liczba wszystkich możliwych porównań prostych wyliczana jest z wzoru:

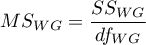

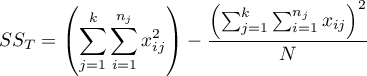

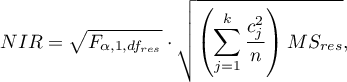

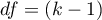

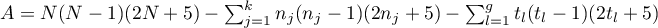

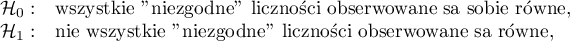

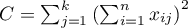

Hipotezy:

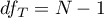

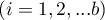

Przykład 1 - porównania proste (porównanie pomiędzy sobą 2 wybranych średnich):

Przykład 2 - porównania złożone (porównanie kombinacji wybranych średnich):

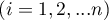

![LaTeX \begin{array}{cc}

\mathcal{H}_0: & \mu_1=\frac{\mu_2+\mu_3}{2},\\[0.1cm]

\mathcal{H}_1: & \mu_1\neq\frac{\mu_2+\mu_3}{2}.

\end{array}](/lib/exe/fetch.php?media=wiki:latex:/imgf0472a7ad15f9b99bbf5ce50cb721339.png)

By można było zdefiniować wybrane hipotezy należy dla każdej średniej przypisać wartość kontrastu  ,

,  . Wartości

. Wartości  są tak wybierane by ich sumy dla porównywanych stron były liczbami przeciwnymi, a ich wartość dla średnich nie biorących udziału w analizie wynosi 0.

są tak wybierane by ich sumy dla porównywanych stron były liczbami przeciwnymi, a ich wartość dla średnich nie biorących udziału w analizie wynosi 0.

- Przykład 1:

,

,  ,

,  .

. - Przykład 2:

,

,  ,

,  ,

,  ,…,

,…,  .

.

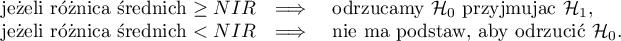

Wyboru właściwej hipotezy możemy dokonać:

Porównując wyznaczoną na podstawie statystyki testowej odpowiedniego testu POST-HOC wartość

Porównując wyznaczoną na podstawie statystyki testowej odpowiedniego testu POST-HOC wartość  z poziomem istotności:

z poziomem istotności:

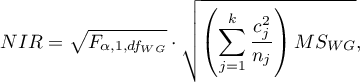

Dla porównań prostych i złożonych, zarówno równolicznych jak i różnolicznych grup, gdy wariancje nie różnią się istotnie.

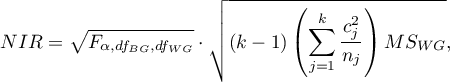

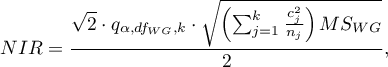

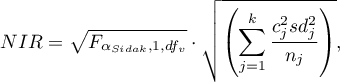

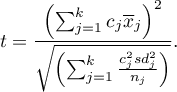

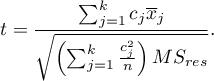

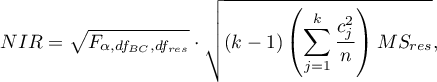

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz dla stopni swobody odpowiednio: 1 i

oraz dla stopni swobody odpowiednio: 1 i  .

.

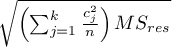

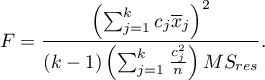

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi t-Studenta z  stopniami swobody.

stopniami swobody.

Dla porównań prostych zarówno równolicznych jak i różnolicznych grup, gdy wariancje nie różnią się istotnie.

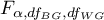

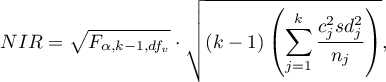

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz

oraz  i

i  stopni swobody.

stopni swobody.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Dla porównań prostych zarówno równolicznych jak i różnolicznych grup, gdy wariancje nie różnią się istotnie.

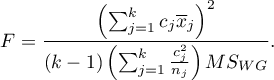

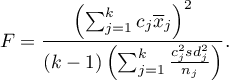

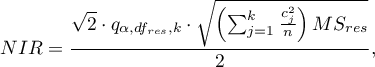

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu studentyzowanego rozstępu dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu studentyzowanego rozstępu dla zadanego poziomu istotności  oraz

oraz  i

i  stopni swobody.

stopni swobody.

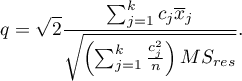

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi studentyzowanego rozstępu z  i

i  stopniami swobody.

stopniami swobody.

Info.

Algorytm obliczania wartości p i statystyki rozkładu studentyzowanego rozstępu w PQStat bazuje na pracy Lunda (1983)1). Inne programy lub strony internetowe mogą wyliczać nieco inne wartości niż PQStat, gdyż mogą bazować na mniej precyzyjnych lub bardziej restrykcyjnych algorytmach (Copenhaver i Holland (1988), Gleason (1999)).

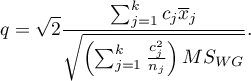

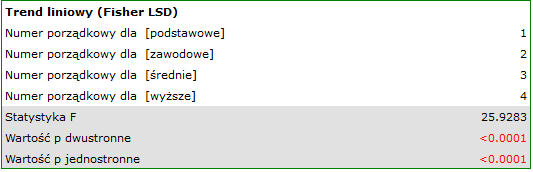

Test badający istnienie trendu może być wyliczany w takiej samej sytuacji jak ANOVA dla zmiennych niezależnych, gdyż bazuje na tych samych założeniach, inaczej jednak ujmuje hipotezę alternatywną - wskazując w niej na istnienie trendu wartości średnich dla kolejnych populacji. Analiza trendu w ułożeniu średnich oparta jest na kontrastach LSD Fishera. Budując odpowiednie kontrasty można badać dowolny rodzaj trendu np. liniowy, kwadratowy, sześcienny, itd. Poniżej znajduje się tabela przykładowych wartości kontrastów dla wybranych trendów.

Trend liniowy

Trend liniowy, tak jak pozostałe trendy, możemy analizować wpisując odpowiednie wartości kontrastów. Jeśli jednak znany jest kierunek trendu liniowego, wystarczy skorzystać z opcji Trend liniowy i wskazać oczekiwaną kolejność populacji przypisując im kolejne liczby naturalne.

Analiza przeprowadzana jest w oparciu o kontrast liniowy, czyli wskazanym według naturalnego uporządkowania grupom przypisane są odpowiednie wartości kontrastu i wyliczona zostaje statystyka LSD Fishera.

Przy znanym oczekiwanym kierunku trendu, hipoteza alternatywna jest jednostronna i interpretacji podlega jednostronna wartość  . Interpretacja dwustronnej wartości

. Interpretacja dwustronnej wartości  oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość

oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Grupy jednorodne

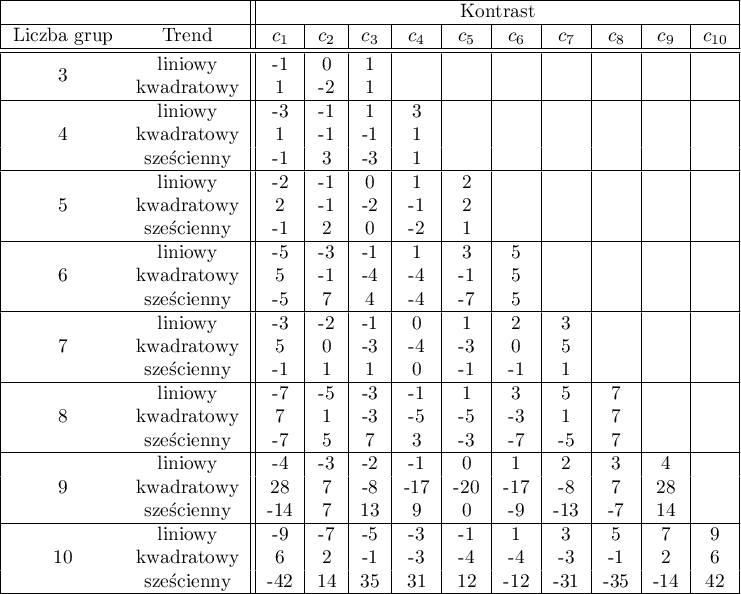

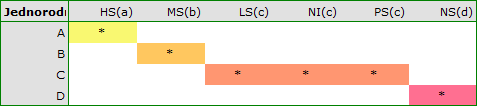

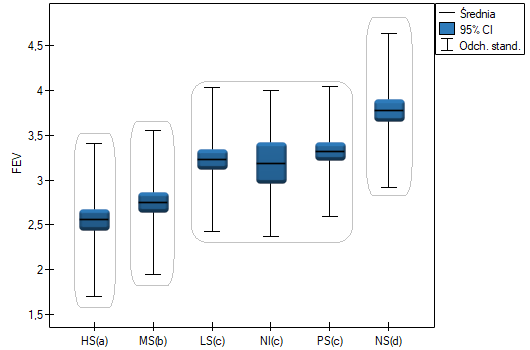

Dla każdego testu post-hoc, budowane są grupy jednorodne. Każda grupa jednorodna przedstawia zbiór grup, które nie różnią się od siebie w sposób istotny statystycznie. Na przykład, załóżmy, że podzieliliśmy badanych na sześć grup odnośnie statusu palenia: Nonsmokers (NS), Passive smokers (PS), Noninhaling smokers (NI), Light smokers (LS), Moderate smokers (MS), Heavy smokers (HS) i badamy dla nich parametry wydechowe. W przeprowadzonej analizie typu ANOVA uzyskaliśmy istotne statystycznie różnice w parametrach wydechowych pomiędzy badanymi grupami. Chcąc wskazać które grupy różnią się istotnie, a które nie, wykonujemy testy typu post-hoc. W rezultacie oprócz tabeli z wynikami poszczególnych par porównań i podanej istotności statystycznej w postaci wartości

uzyskujemy podział na grupy jednorodne:

W tym przypadku uzyskano 4 grupy jednorodne tzn. A, B, C i D, co wskazuje na możliwość przeprowadzania badania w oparciu o mniejszy podział tzn. zamiast sześciu grup, które badaliśmy pierwotnie można prowadzić dalsze analizy w oparciu o cztery wyznaczone tu grupy jednorodne. Kolejność grup ustalona została na podstawie średnich ważonych wyliczonych dla poszczególnych grup jednorodnych, w taki sposób, by litera A przypisana została go grupy o najniższej średniej ważonej średniej ważonej, a dalsze litery alfabetu kolejno do grup o coraz wyższych średnich.

Okno z ustawieniami opcji jednoczynnikowej ANOVA dla grup niezależnych wywołujemy poprzez menu Statystyka→Testy parametryczne→ANOVA dla grup niezależnych lub poprzez Kreator.

2014/08/22 20:00

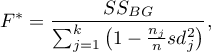

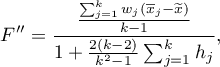

ANOVA dla grup niezależnych z korektą F* i F''

Poprawki

Poprawki  (Brown-Forsythe, 19742)) oraz

(Brown-Forsythe, 19742)) oraz  (Welch, 19513)) dotyczą ANOVA dla grup niezależnych i są wyliczane wówczas, gdy nie jest spełnione założenie równości wariancji.

(Welch, 19513)) dotyczą ANOVA dla grup niezależnych i są wyliczane wówczas, gdy nie jest spełnione założenie równości wariancji.

Statystyka testowa ma postać:

gdzie:

odchylenie standardowe grupy

odchylenie standardowe grupy  ,

,

waga grupy

waga grupy  ,

,

średnia ważona,

średnia ważona,

.

.

Statystyka ta podlega rozkładowi F Snedecora z  i skorygowanymi

i skorygowanymi  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Testy POST-HOC

Wprowadzenie do kontrastów i testów POST-HOC przeprowadzone zostało w rozdziale dotyczącym jednoczynnikowej analizy wariancji.

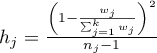

Dla porównań prostych i złożonych zarówno równolicznych jak i różnolicznych grup, gdy wariancje różnią się istotnie (Tamhane A. C., 19774)).

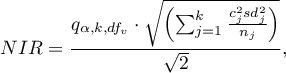

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to|wartość krytyczna (statystyka) rozkładu F Snedecora dla zmodyfikowanego poziomu istotności

- to|wartość krytyczna (statystyka) rozkładu F Snedecora dla zmodyfikowanego poziomu istotności  oraz dla stopni swobody 1 i

oraz dla stopni swobody 1 i  odpowiednio,

odpowiednio,

,

,

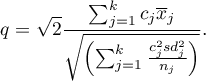

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi t-Studenta z  stopniami swobody, a wartość p jest korygowana o liczbę możliwych porównań prostych.

stopniami swobody, a wartość p jest korygowana o liczbę możliwych porównań prostych.

Test BF (Brown-Forsythe)

Dla porównań prostych zarówno równolicznych jak i różnolicznych grup, gdy wariancje różnią się istotnie (Brown M. B. i Forsythe A. B. (1974)5)).

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz

oraz  i

i  stopni swobody.

stopni swobody.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Test GH (Games-Howell).

Dla porównań prostych zarówno równolicznych jak i różnolicznych grup, gdy wariancje różnią się istotnie (Games P. A. i Howell J. F. 19766)).

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu studentyzowanego rozstępu dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu studentyzowanego rozstępu dla zadanego poziomu istotności  oraz

oraz  i

i  stopni swobody.

stopni swobody.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi studentyzowanego rozstępu z  i

i  stopniami swobody.

stopniami swobody.

Test dla trendu.

Test badający istnienie trendu może być wyliczany w takiej samej sytuacji jak ANOVA dla grup niezależnych z korektą  i

i  , gdyż bazuje na tych samych założeniach, inaczej jednak ujmuje hipotezę alternatywną - wskazując w niej na istnienie trendu wartości średnich dla kolejnych populacji. Analiza trendu w ułożeniu średnich oparta jest na kontrastach (T2 Tamhane). Budując odpowiednie kontrasty można badać dowolny rodzaj trendu np. liniowy, kwadratowy, sześcienny, itd. Tabela przykładowych wartości kontrastów dla wybranych trendów znajduje się w opisie testu dla trendu dla ANOVA bez korekty dla różnych wariancji.

, gdyż bazuje na tych samych założeniach, inaczej jednak ujmuje hipotezę alternatywną - wskazując w niej na istnienie trendu wartości średnich dla kolejnych populacji. Analiza trendu w ułożeniu średnich oparta jest na kontrastach (T2 Tamhane). Budując odpowiednie kontrasty można badać dowolny rodzaj trendu np. liniowy, kwadratowy, sześcienny, itd. Tabela przykładowych wartości kontrastów dla wybranych trendów znajduje się w opisie testu dla trendu dla ANOVA bez korekty dla różnych wariancji.

Trend liniowy

Trend liniowy, tak jak pozostałe trendy, możemy analizować wpisując odpowiednie wartości kontrastów. Jeśli jednak znany jest kierunek trendu liniowego, wystarczy skorzystać z opcji Trend liniowy i wskazać oczekiwaną kolejność populacji przypisując im kolejne liczby naturalne.

Analiza przeprowadzana jest w oparciu o kontrast liniowy, czyli wskazanym według naturalnego uporządkowania grupom przypisane są odpowiednie wartości kontrastu i wyliczona zostaje statystyka T2 Tamhane.

Przy znanym oczekiwanym kierunku trendu, hipoteza alternatywna jest jednostronna i interpretacji podlega jednostronna wartość  . Interpretacja dwustronnej wartości

. Interpretacja dwustronnej wartości  oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość

oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Okno z ustawieniami opcji jednoczynnikowej ANOVA dla grup niezależnych z korektą F* i F„ wywołujemy poprzez menu Statystyka→Testy parametryczne→ANOVA dla grup niezależnych lub poprzez Kreator.

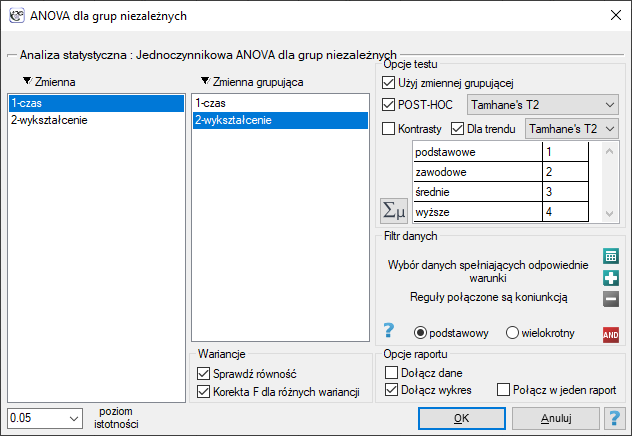

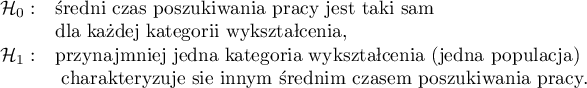

Przykład (plik bezrobocie.pqs)

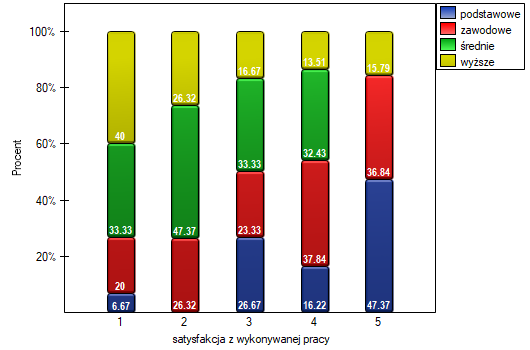

Jest wiele czynników regulujących czas poszukiwania pracy w dobie kryzysu gospodarczego. Jednym z najważniejszych może być poziom wykształcenia. Przykładowe dane dotyczące wykształcenia oraz czasu (w miesiącach) pozostawania bezrobotnym zebrano w pliku. Chcemy sprawdzić czy istnieją różnice w średnim czasie poszukiwania pracy dla poszczególnych kategorii wykształcenia.

Hipotezy:

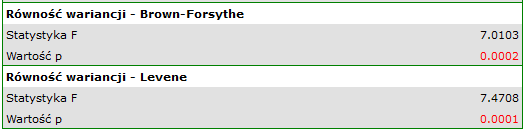

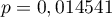

Ze względu na różnice dotyczące wariancji pomiędzy poszczególnymi populacjami (dla testu Levene wartość  , a dla testu Brown-Forsythe wartość

, a dla testu Brown-Forsythe wartość  ):

):

analizę przeprowadzamy przy włączonej korekcie różnych wariancji. Uzyskany wynik skorygowanej statystyki  jest przedstawiony poniżej.

jest przedstawiony poniżej.

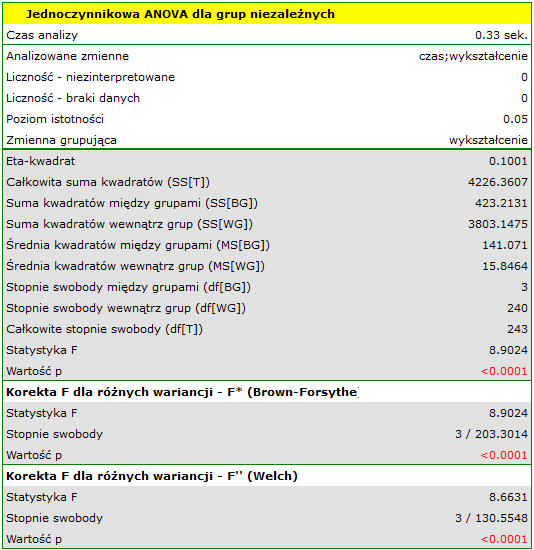

Porównując wartość  (dla testu

(dla testu  ) oraz wartość

) oraz wartość  (dla testu

(dla testu  ) z poziomem istotności

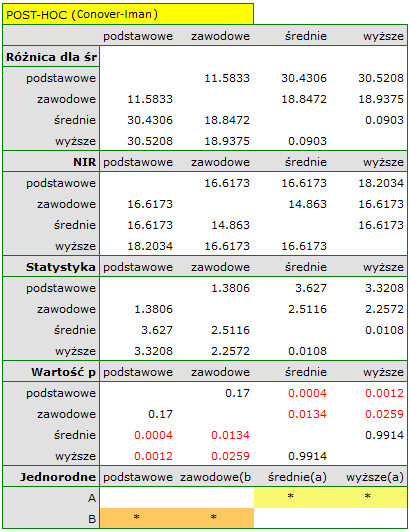

) z poziomem istotności  stwierdzamy, że średni czas poszukiwania pracy różni się w zależności od posiadanego wykształcenia. Wykonując jeden z testów POST-HOC, dedykowany porównaniu grup o różnych wariancjach, dowiadujemy się których kategorii wykształcenia dotyczą stwierdzone różnice:

stwierdzamy, że średni czas poszukiwania pracy różni się w zależności od posiadanego wykształcenia. Wykonując jeden z testów POST-HOC, dedykowany porównaniu grup o różnych wariancjach, dowiadujemy się których kategorii wykształcenia dotyczą stwierdzone różnice:

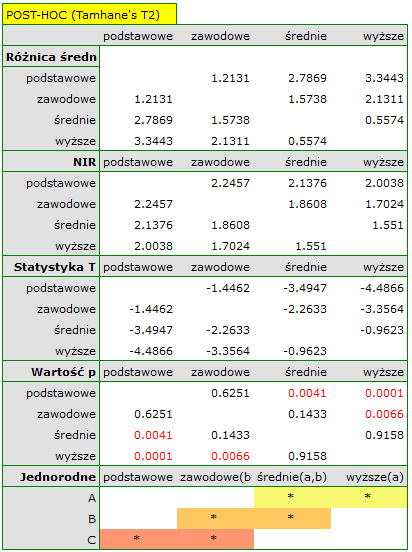

Najmniejsza istotna różnica (NIR) wyznaczona dla każdej pary porównań nie jest taka sama (mimo, że liczności grup są sobie równe), ponieważ nie są równe wariancje. Odnosząc wartość NIR do uzyskanych różnic wartości średnich uzyskamy ten sam rezultat co porównując wartość  z poziomem istotności

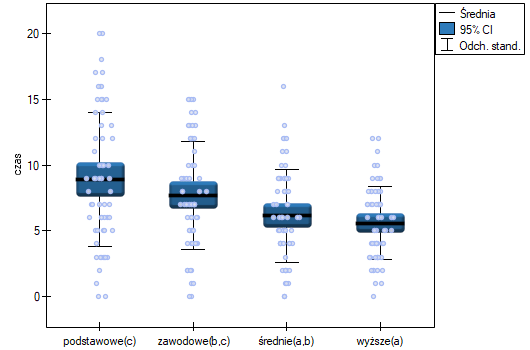

z poziomem istotności  . Różnice dotyczą wykształcenia podstawowego i wyższego, wykształcenia podstawowego i średniego oraz wykształcenia zawodowego i wyższego. Powstałe grupy jednorodne zazębiają się. Generalnie jednak, spoglądając na wykres, możemy oczekiwać, że czym bardziej wykształcona osoba, tym mniej czasu zajmuje jej poszukiwanie pracy.

. Różnice dotyczą wykształcenia podstawowego i wyższego, wykształcenia podstawowego i średniego oraz wykształcenia zawodowego i wyższego. Powstałe grupy jednorodne zazębiają się. Generalnie jednak, spoglądając na wykres, możemy oczekiwać, że czym bardziej wykształcona osoba, tym mniej czasu zajmuje jej poszukiwanie pracy.

By móc sprawdzić tak postawioną hipotezę, należy podjąć analizę dla trendu. W tym celu {wznawiamy analizę} przyciskiem  i w oknie opcji testu wybieramy: metodę

i w oknie opcji testu wybieramy: metodę Tamhane's T2, opcję Kontrasy (i ustawiamy odpowiedni kontrast) lub opcję Dla trendu (i wskazujemy kolejność kategorii wykształcenia podając kolejne liczby naturalne).

W zależności od tego czy kierunek zależności pomiędzy wykształceniem a czasem poszukiwania pracy jest nam znany, wykorzystujemy jednostronną lub dwustronną wartość  . Obie te wartości są mniejsze niż zadany poziom istotności. Przewidywany przez nas trend został potwierdzony, czyli na poziomie istotności

. Obie te wartości są mniejsze niż zadany poziom istotności. Przewidywany przez nas trend został potwierdzony, czyli na poziomie istotności  możemy powiedzieć, że ów trend istnieje rzeczywiście w populacji z której pochodzi próba.

możemy powiedzieć, że ów trend istnieje rzeczywiście w populacji z której pochodzi próba.

2014/12/18 00:41

· admin

Test Browna-Forsythea i Levenea

Obydwa testy: test Levenea (ang. Levene test), Levene (1960)7) i test Browna-Forsythea (ang. Brown-Forsythe test), Brown i Forsythe (1974)8), służą do weryfikacji hipotezy o równości wariancji badanej zmiennej w kilku ( ) populacjach.

) populacjach.

Podstawowe warunki stosowania:

- pomiar na skali interwałowej,

- normalność rozkładu badanej zmiennej w każdej populacji,

Hipotezy:

gdzie:

,

, ,…,

,…, - wariancje badanej zmiennej w populacjach, z których pobrano próby.

- wariancje badanej zmiennej w populacjach, z których pobrano próby.

Analiza polega na wyznaczaniu bezwzględnego odchylenia wyników pomiarowych od średniej (w teście Levenea) lub od mediany (w teście Browna-Forsythea), w każdej z badanych grup. Owo bezwzględne odchylenie stanowi dane, które zostają poddane dokładnie tej samej procedurze, którą wykonuje się dla analizy wariancji dla grup niezależnych. Stąd statystyka testowa przyjmuje postać:

Statystyka ta podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Uwaga!

Test Browna-Forsythea jest mniej wrażliwy niż test Levenea na niespełnienie założenia dotyczącego normalności rozkładu.

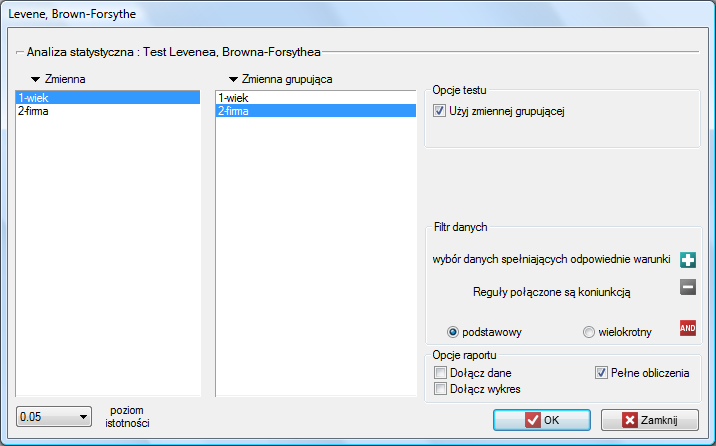

Okno z ustawieniami opcji testu Levenea, Browna-Forsythea wywołujemy poprzez menu Statystyka→Testy parametryczne→Levene, Brown-Forsythe.

2014/08/22 20:00

ANOVA powtarzanych pomiarów

Jednoczynnikowa analiza wariancji dla powtarzanych pomiarów, czyli ANOVA dla grup zależnych (ang. single-factor repeated-measures analysis of variance) stosuje się w sytuacji, gdy pomiarów badanej zmiennej dokonujemy kilkukrotnie ( ) w różnych warunkach (przy czym zakładamy, że wariancje różnic pomiędzy wszystkimi parami pomiarów są sobie bliskie).

) w różnych warunkach (przy czym zakładamy, że wariancje różnic pomiędzy wszystkimi parami pomiarów są sobie bliskie).

Test ten służy do weryfikacji hipotezy o równości średnich badanej zmiennej w kilku ( ) populacjach.

) populacjach.

Podstawowe warunki stosowania:

- pomiar na skali interwałowej,

- normalność rozkładu dla wszystkich zmiennych będących różnicą par pomiarowych (lub normalność badanej zmiennej dla każdego pomiaru),

Hipotezy:

gdzie:

,

, ,…,

,…, - średnie badanej zmiennej w kolejnych pomiarach z badanej populacji.

- średnie badanej zmiennej w kolejnych pomiarach z badanej populacji.

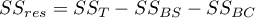

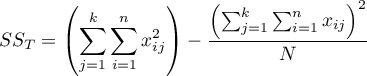

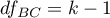

Statystyka testowa ma postać:

gdzie:

-średnia kwadratów między pomiarami,

-średnia kwadratów między pomiarami,

- średnia kwadratów dla reszt,

- średnia kwadratów dla reszt,

- suma kwadratów między pomiarami,

- suma kwadratów między pomiarami,

- suma kwadratów dla reszt,

- suma kwadratów dla reszt,

- całkowita suma kwadratów,

- całkowita suma kwadratów,

- suma kwadratów między obiektami,

- suma kwadratów między obiektami,

- stopnie swobody (między pomiarami),

- stopnie swobody (między pomiarami),

- stopnie swobody (dla reszt),

- stopnie swobody (dla reszt),

- całkowite stopnie swobody,

- całkowite stopnie swobody,

- stopnie swobody (między obiektami),

- stopnie swobody (między obiektami),

,

,

- liczność próby,

- liczność próby,

- wartości zmiennej dla

- wartości zmiennej dla  obiektów

obiektów  w

w  pomiarach

pomiarach  .

.

Statystyka ta podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Wielkość efektu - cząstkowa

Wielkość ta określa proporcję wariancji wyjaśnionej do wariancji całkowitej związanej z danym czynnikiem. Zatem w modelu powtarzanych pomiarów wskazuje jaka część wewnątrzosobowej zmienności wyników może być przypisana powtarzanym pomiarom zmiennej.

Testy POST-HOC

Wprowadzenie do kontrastów i testów POST-HOC przeprowadzone zostało w rozdziale dotyczącym jednoczynnikowej analizy wariancji.

Dla porównań prostych i złożonych (liczność w poszczególnych pomiarach zawsze jest taka sama).

Hipotezy:

Przykład - porównania proste (porównanie pomiędzy sobą 2 wybranych średnich):

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz dla stopni swobody odpowiednio: 1 i

oraz dla stopni swobody odpowiednio: 1 i  .

.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi t-Studenta z  stopniami swobody.

stopniami swobody.

Uwaga!

Dla kontrastów wielkość  zastąpiona jest błędem kontrastu

zastąpiona jest błędem kontrastu  , a stopnie swobody to

, a stopnie swobody to  .

.

Dla porównań prostych (liczność w poszczególnych pomiarach zawsze jest taka sama).

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz

oraz  i

i  stopni swobody.

stopni swobody.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Dla porównań prostych (liczność w poszczególnych pomiarach zawsze jest taka sama).

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu studentyzowanego rozstępu dla zadanego poziomu istotności

- to wartość krytyczna (statystyka) rozkładu studentyzowanego rozstępu dla zadanego poziomu istotności  oraz

oraz  i

i  stopni swobody.

stopni swobody.

] Statystyka testowa ma postać:

] Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi studentyzowanego rozstępu  i

i  stopniami swobody.

stopniami swobody.

Info.

Algorytm obliczania wartości p i statystyki rozkładu studentyzowanego rozstępu w PQStat bazuje na pracy Lunda (1983)9). Inne programy lub strony internetowe mogą wyliczać nieco inne wartości niż PQStat, gdyż mogą bazować na mniej precyzyjnych lub bardziej restrykcyjnych algorytmach (Copenhaver i Holland (1988), Gleason (1999)).

Test dla trendu.

Test badający istnienie trendu może być wyliczany w takiej samej sytuacji jak ANOVA dla zmiennych zależnych, gdyż bazuje na tych samych założeniach, inaczej jednak ujmuje hipotezę alternatywną - wskazując w niej na istnienie trendu wartości średnich w kolejnych pomiarach. Analiza trendu w ułożeniu średnich oparta jest na kontrastach Test LSD Fishera. Budując odpowiednie kontrasty można badać dowolny rodzaj trendu np. liniowy, kwadratowy, sześcienny, itd. Tabela przykładowych wartości kontrastów dla wybranych trendów znajduje się w opisie testu dla trendu dla ANOVA zmiennych niezależnych.

Trend liniowy

Trend liniowy, tak jak pozostałe trendy, możemy analizować wpisując odpowiednie wartości kontrastów. Jeśli jednak znany jest kierunek trendu liniowego, wystarczy skorzystać z opcji Trend liniowy i wskazać oczekiwaną kolejność populacji przypisując im kolejne liczby naturalne.

Analiza przeprowadzana jest w oparciu o kontrast liniowy, czyli wskazanym według naturalnego uporządkowania grupom przypisane są odpowiednie wartości kontrastu i wyliczona zostaje statystyka Test LSD Fishera.

Przy znanym oczekiwanym kierunku trendu, hipoteza alternatywna jest jednostronna i interpretacji podlega jednostronna wartość  . Interpretacja dwustronnej wartości

. Interpretacja dwustronnej wartości  oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość

oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

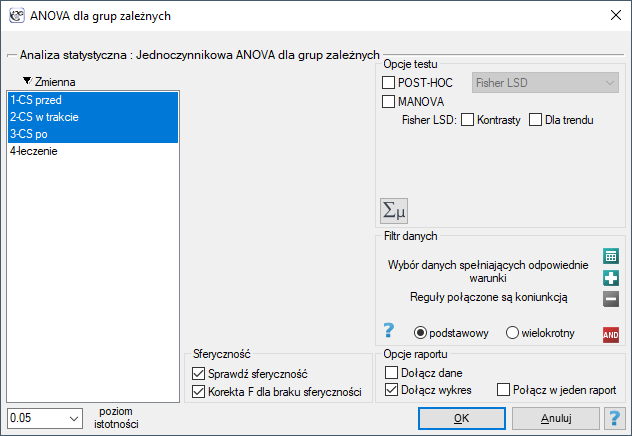

Okno z ustawieniami opcji jednoczynnikowej ANOVA dla grup zależnych wywołujemy poprzez menu Statystyka→Testy parametryczne→ANOVA dla grup zależnych lub poprzez Kreator.

Patrz przykład (plik ciśnienie.pqs)

2014/08/22 20:00

ANOVA powtarzanych pomiarów z korektą Epsilon i MANOVA

Poprawki Epsilon i MANOVA dotyczą ANOVA powtarzanych pomiarów i są wyliczane wówczas, gdy nie jest spełnione założenie sferyczności lub wariancje różnic pomiędzy wszystkimi parami pomiarów nie są sobie bliskie.

Korekta braku sferyczności

Stopień w jakim sferyczność jest spełniona jest reprezentowany przez wartość  w teście Mauchly’a, ale również przez wartości Epsilon (

w teście Mauchly’a, ale również przez wartości Epsilon ( ) wyliczane wraz z korektami.

) wyliczane wraz z korektami.  oznacza ścisłe przestrzeganie warunku sferyczności. Im mniejsza od 1 jest wartość Epsilon, tym założenie sferyczności jest bardziej naruszone. Dolna granica jaką Epsilon może osiągnąć to

oznacza ścisłe przestrzeganie warunku sferyczności. Im mniejsza od 1 jest wartość Epsilon, tym założenie sferyczności jest bardziej naruszone. Dolna granica jaką Epsilon może osiągnąć to  .

.

W celu zminimalizowania skutków braku sferyczności można wykorzystać trzy korekty zmieniające liczbę stopni swobody przy testowaniu z rozkładu F. Najprostszą lecz najsłabszą jest korekta dolnej granicy Epsilon. Nieco silniejszą lecz również konserwatywną jest korekta Greenhouse-Geisser (1959)10). Największą mocą charakteryzuje się korekta Huynh-Feldt (1976)11). Przy znacznym naruszeniu sferyczności najbardziej wskazanym rozwiązaniem jest jednak wykonanie analizy, która tego założenie nie wymaga, czyli MANOVA.

Podejście wielowymiarowe - MANOVA

MANOVA (ang. multivariate analysis of variance) czyli wielowymiarowa ANOVA jest analizą nie zakładającą sferyczności. W przypadku niespełnienia tego założenia jest to metoda najefektywniejsza, więc powinna być wybierana w zastępstwie analizy wariancji dla powtarzanych pomiarów. Omówienie tej metody można znaleźć w rozdziale jednoczynnikowa MANOVA. Zastosowanie jej do pomiarów powtarzanych (bez czynnika grup niezależnych) ogranicza jej działanie do danych będących różnicą sąsiadujących pomiarów i zapewnia testowanie tej samej hipotezy, co ANOVA dla zmiennych zależnych.

Okno z ustawieniami opcji jednoczynnikowej ANOVA dla grup zależnych z korektą Epsilon i MANOVA wywołujemy poprzez menu Statystyka→Testy parametryczne→ANOVA dla grup zależnych lub poprzez Kreator.

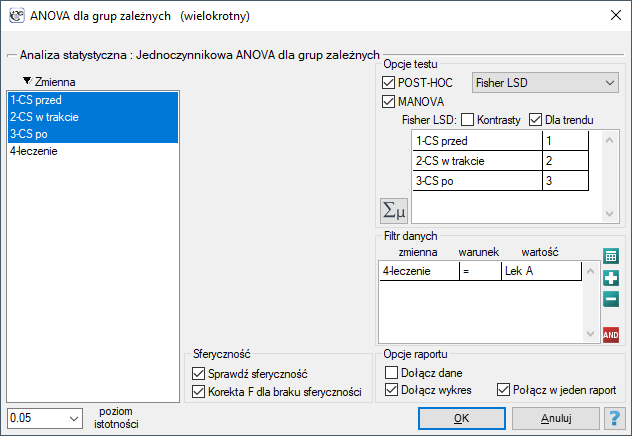

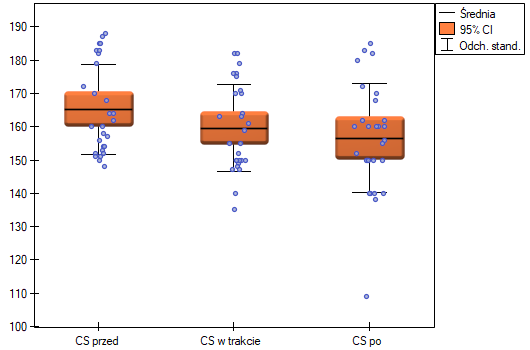

Badano skuteczność dwóch metod leczenia nadciśnienia. W tym celu zebrano próbę 56 chorych i przydzielono ich losowo do dwóch grup: grupy leczonej lekiem A i grupy leczonej lekiem B. Pomiaru ciśnienia skurczowego w każdej grupie dokonano trzykrotnie: przed leczeniem, w trakcie leczenia i po 6 miesiącach prowadzenia kuracji.

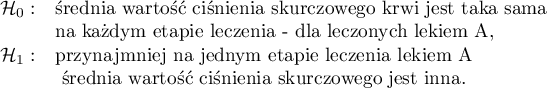

Hipotezy dla leczonych lekiem A:

Hipotezy dla leczonych lekiem B brzmią analogicznie.

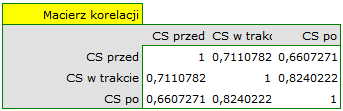

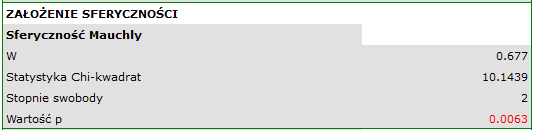

Ponieważ dane mają rozkład normalny, analizę rozpoczynamy od sprawdzenia założenia o sferyczności. Testowanie wykonujemy dla każdej grupy osobno wykorzystując filtr wielokrotny.

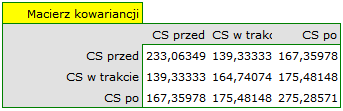

Na niespełnienie założenia sferyczności przez grupę leczoną lekiem B wskazują zarówno obserwowane wartości macierzy kowariancji i korelacji, jak i wynik testu Mauchly’a ( , wartość

, wartość  ).

).

Wznawiamy analizę  i w oknie opcji testu wybieramy filtr podstawowy, by wykonać ANOVA powtarzanych pomiarów - dla leczonych lekiem A, a następnie korektę tej analizy i statystykę MANOVA - dla leczonych lekiem B.

i w oknie opcji testu wybieramy filtr podstawowy, by wykonać ANOVA powtarzanych pomiarów - dla leczonych lekiem A, a następnie korektę tej analizy i statystykę MANOVA - dla leczonych lekiem B.

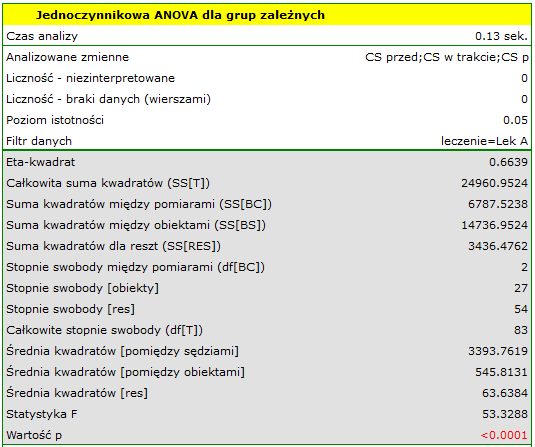

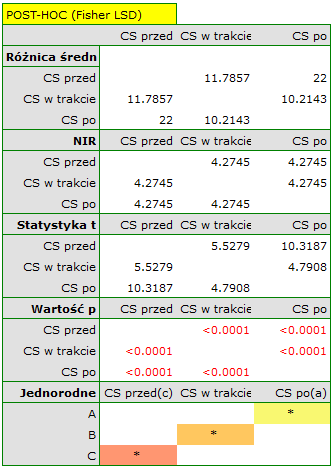

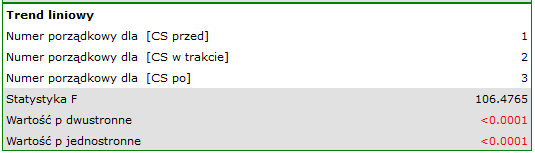

Wyniki dla leczonych lekiem A:

wskazują na istotne (na poziomie istotności  ) różnice pomiędzy średnimi wartościami ciśnienia skurczowego (wartość

) różnice pomiędzy średnimi wartościami ciśnienia skurczowego (wartość  dla ANOVA powtarzanych pomiarów). Ponad 66% wewnątrzosobowego zróżnicowania wyników może być tłumaczona zastosowaniem leku A (

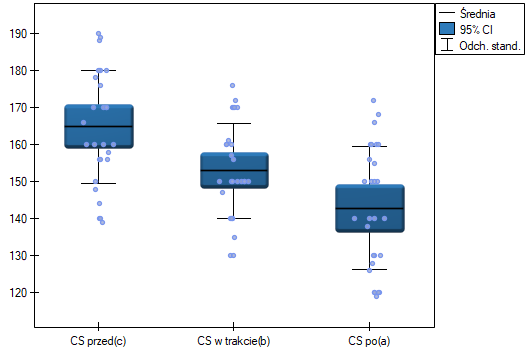

dla ANOVA powtarzanych pomiarów). Ponad 66% wewnątrzosobowego zróżnicowania wyników może być tłumaczona zastosowaniem leku A ( ). Różnice dotyczą wszystkich porównywanych etapów leczenia (wynik POST-HOC). Istotny jest również trend spadku ciśnienia skurczowego na skutek leczenia (wartość

). Różnice dotyczą wszystkich porównywanych etapów leczenia (wynik POST-HOC). Istotny jest również trend spadku ciśnienia skurczowego na skutek leczenia (wartość  ). Zatem Lek A możemy uznać za lek skuteczny.

). Zatem Lek A możemy uznać za lek skuteczny.

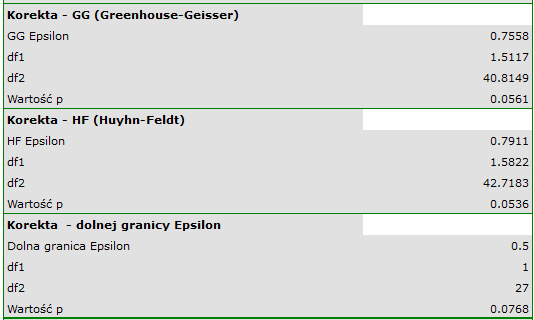

Wyniki dla leczonych lekiem B:

wskazują na brak istotnych różnic pomiędzy średnimi wartościami ciśnienia skurczowego, zarówno wtedy, gdy korzystamy z poprawek epsilon, jak i Lambda Wilksa (MANOVA). Zaledwie niecałe 17% wewnątrzosobowego zróżnicowania wyników może być tłumaczone zastosowaniem leku B ( ).

).

2014/12/18 16:03

· admin

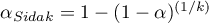

Sferyczność Mauchly’a

Założenie sferyczności jest podobne ale silniejsze niż założenie równości wariancji. Jest ono spełnione, jeśli wariancje dla różnic pomiędzy parami powtarzanych pomiarów są takie same. Zwykle w zastępstwie założenia o sferyczności rozważa się prostszy, ale bardziej rygorystyczny warunek symetrii połączonej (ang. compound symmetry). Można tak postąpić ponieważ spełnienie warunku symetrii połączonej pociąga za sobą spełnienie założenia sferyczności.

Warunek symetrii połączonej zakłada symetrię w macierzy kowariancji, a zatem równość wariancji zmiennych (elementów głównej przekątnej macierzy kowariancji) oraz równość kowariancji (elementów poza główną przekątną macierzy kowariancji).

Naruszenie założenia sferyczności lub symetrii połączonej zmniejsza w nieuzasadniony sposób konserwatyzm testu F (ułatwia odrzucenie hipotezy zerowej).

Dla sprawdzenia założenia sferyczności używa się testu Mauchly’a (1940)12). Istotność wyniku ( ) oznacza tu naruszenie założenia sferyczności.

) oznacza tu naruszenie założenia sferyczności.

Podstawowe warunki stosowania:

- pomiar na skali interwałowej,

- wielowymiarowy rozkład normalny lub normalność rozkładu każdej badanej zmiennej,

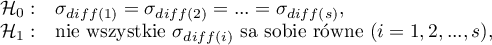

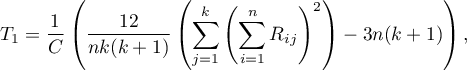

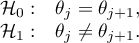

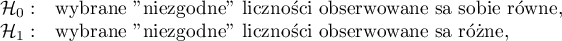

Hipotezy:

gdzie:

- populacyjna wariancja różnic pomiędzy

- populacyjna wariancja różnic pomiędzy  -tą parą powtarzanych pomiarów,

-tą parą powtarzanych pomiarów,

- liczba par.

- liczba par.

Wartość  Mauchly’a definiowana jest następująco:

Mauchly’a definiowana jest następująco:

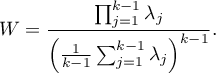

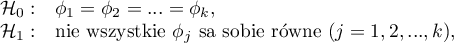

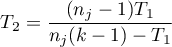

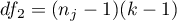

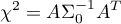

Statystyka testowa ma postać:

gdzie:

,

,

- wartość własna oczekiwanej macierzy kowariancji,

- wartość własna oczekiwanej macierzy kowariancji,

- liczba analizowanych zmiennych.

- liczba analizowanych zmiennych.

Statystyka ta ma asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Wartość  oznacza spełnienie założenia sferyczności. W interpretacji wyników tego testu należy jednak pamiętać, że jest on wrażliwy na złamanie założenia normalności rozkładu.

oznacza spełnienie założenia sferyczności. W interpretacji wyników tego testu należy jednak pamiętać, że jest on wrażliwy na złamanie założenia normalności rozkładu.

Patrz przykład (plik ciśnienie.pqs)

2014/12/18 15:58

· admin

2014/08/22 20:00

Testy nieparametryczne

ANOVA Kruskala-Wallisa

Jednoczynnikowa analiza wariancji dla rang Kruskala-Walisa, czyli ANOVA Kruskala-Wallisa (ang. Kruskal-Wallis one-way analysis of variance by ranks) opisana przez Kruskala (1952)13) oraz Kruskala i Wallisa (1952)14) jest rozszerzeniem testu U-Manna-Whitneya na więcej niż dwie populacje. Test ten służy do weryfikacji hipotezy o braku przesunięcia porównywanych rozkładów tzn. najczęsciej nieistotności różnic pomiędzy medianami badanej zmiennej w kilku ( ) populacjach (przy czym zakładamy, że rozkłady zmiennej są sobie bliskie - porównanie wariancji rang można sprawdzić testem dla rang Conovera).

) populacjach (przy czym zakładamy, że rozkłady zmiennej są sobie bliskie - porównanie wariancji rang można sprawdzić testem dla rang Conovera).

Dodatkowe analizy:

- możliwe jest testowanie trendu w ułożeniu badanych grup poprzez wykonanie testu Jonckheere-Terpstra dla trendu.

Podstawowe warunki stosowania:

- pomiar na skali porządkowej lub interwałowej,

Hipotezy dotyczą równości średnich rang dla kolejnych populacji lub są upraszczane do median:

gdzie:

to rozkłady badanej zmiennej w populacjach, z których pobrano próby.

to rozkłady badanej zmiennej w populacjach, z których pobrano próby.

Statystyka testowa ma postać:

gdzie:

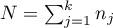

,

,

- liczności prób dla

- liczności prób dla  ,

,

- rangi przypisane do wartości zmiennej, dla

- rangi przypisane do wartości zmiennej, dla  ,

,  ,

,

- korekta na rangi wiązane,

- korekta na rangi wiązane,

- liczba przypadków wchodzących w skład rangi wiązanej.

- liczba przypadków wchodzących w skład rangi wiązanej.

Wzór na statystykę testową  zawiera poprawkę na rangi wiązane

zawiera poprawkę na rangi wiązane  . Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych poprawka ta nie jest wyliczana, gdyż wówczas

. Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych poprawka ta nie jest wyliczana, gdyż wówczas  ).

).

Statystyka  ma asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z liczbą stopni swobody wyznaczaną według wzoru:

ma asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z liczbą stopni swobody wyznaczaną według wzoru:  .

.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Testy POST-HOC

Wprowadzenie do kontrastów i testów POST-HOC przeprowadzone zostało w rozdziale dotyczącym jednoczynnikowej analizy wariancji.

Dla porównań prostych, zarówno równolicznych jak i różnolicznych grup.

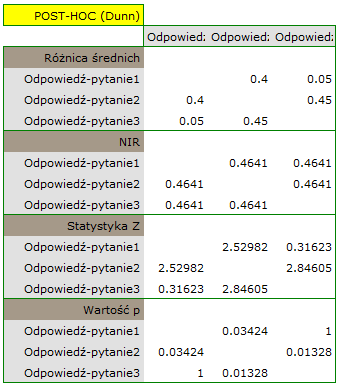

Test Dunna (Dunn 196415)) zawiera poprawkę na rangi wiązane (Zar 201016)) i jest testem korygowanym ze względu na wielokrotne testowanie. Najczęściej wykorzystuje się tu korektę Bonferroniego lub Sidaka, chociaż dostępne są również inne, nowsze korekty opisane szerzej w dziale Wielokrotne porównania.

Przykład - porównania proste (porównanie pomiędzy sobą 2 wybranych median / średnich rang):

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

liczba przypadków wchodzących w skład rangi wiązanej

liczba przypadków wchodzących w skład rangi wiązanej

- to wartość krytyczna (statystyka) rozkładu normalnego dla poziomu istotności

- to wartość krytyczna (statystyka) rozkładu normalnego dla poziomu istotności  skorygowanego o liczbę możliwych porównań prostych

skorygowanego o liczbę możliwych porównań prostych  zgodnie z wybraną poprawką.

zgodnie z wybraną poprawką.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

gdzie:

- średnia rang

- średnia rang  -tej grupy, dla

-tej grupy, dla  ,

,

Wzór na statystykę testową  zawiera poprawkę na rangi wiązane. Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych poprawka ta nie jest wyliczana, ponieważ

zawiera poprawkę na rangi wiązane. Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych poprawka ta nie jest wyliczana, ponieważ  ).

).

Statystyka ta ma asymptotycznie (dla dużych liczności próby) rozkład normalny, a wartość p jest korygowana o liczbę możliwych porównań prostych  zgodnie z wybraną poprawką.

zgodnie z wybraną poprawką.

Nieparametryczny odpowiednik LSD Fishera17), stosowany dla porównań prostych zarówno równolicznych jak i różnolicznych grup.

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz dla stopni swobody odpowiednio: 1 i

oraz dla stopni swobody odpowiednio: 1 i  .

.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

gdzie:

- średnia rang

- średnia rang  -tej grupy, dla

-tej grupy, dla  ,

,

Statystyka ta podlega rozkładowi t-Studenta z  stopniami swobody.

stopniami swobody.

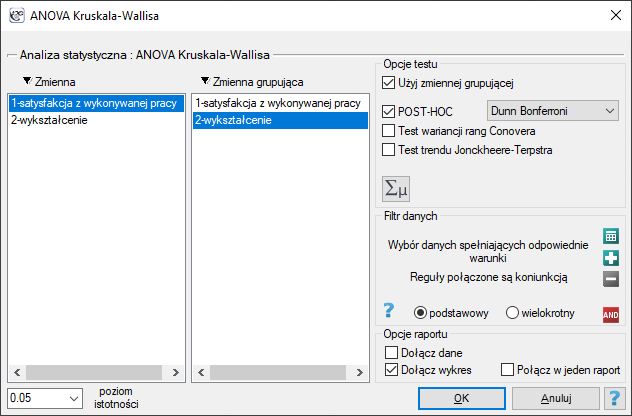

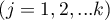

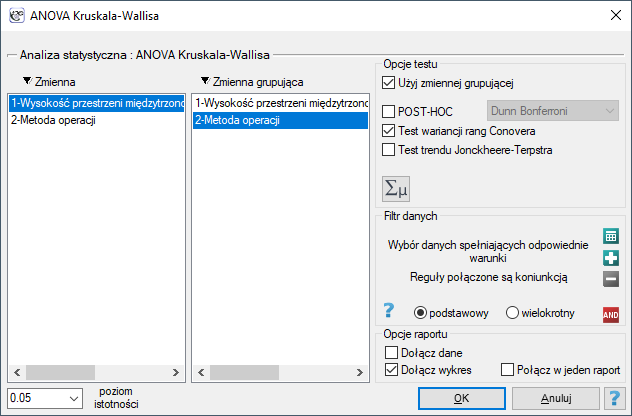

Okno z ustawieniami opcji ANOVA Kruskala-Wallisa wywołujemy poprzez menu Statystyka→Testy nieparametryczne→ANOVA Kruskala-Wallisa lub poprzez Kreator.

Przykład (satysfakcjaZpracy.pqs)

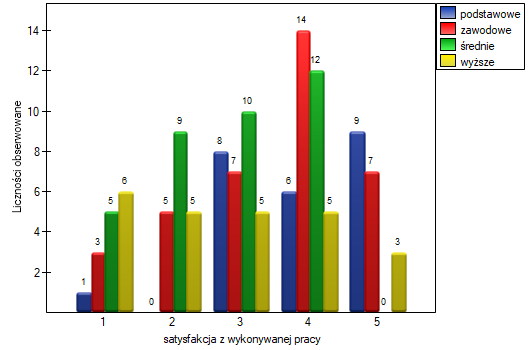

Przepytano grupę 120 osób, dla których wykonywane zajęcie jest ich pierwszą pracą uzyskaną po otrzymaniu odpowiedniego wykształcenia. Ankietowani oceniali satysfakcję z wykonywanej pracy w pięciostopniowej skali, gdzie:

1- praca niesatysfakcjonująca,

2- praca dająca niewielką satysfakcję,

3- praca dająca przeciętny poziom satysfakcji,

4- praca dająca dość dużą satysfakcję ,

5- praca bardzo satysfakcjonująca.

Sprawdzimy czy poziom deklarowanej satysfakcji z pracy nie zmienia się dla poszczególnych kategorii wykształcenia.

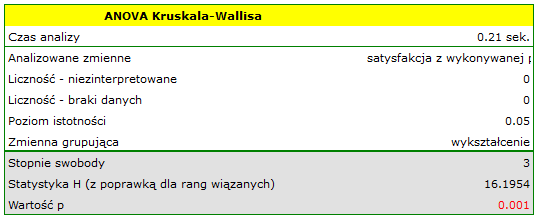

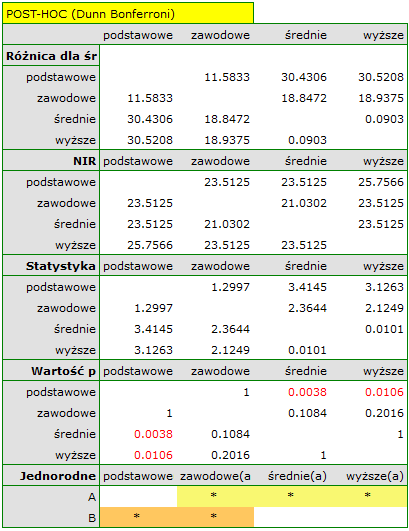

Hipotezy:

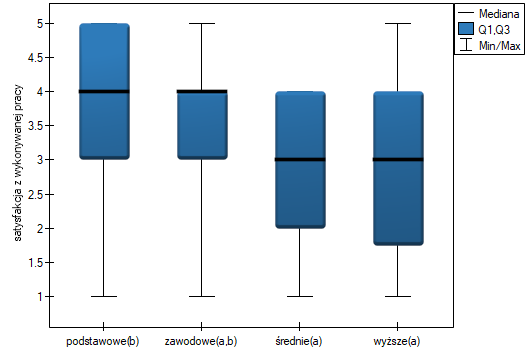

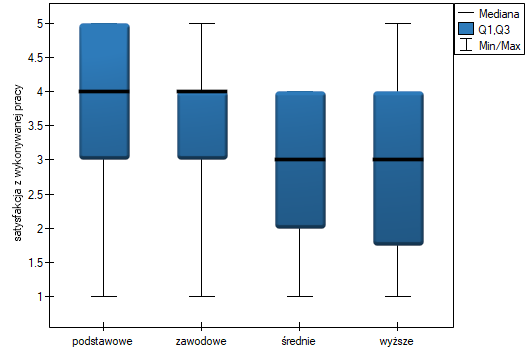

Uzyskana wartość  świadczy o istotnej różnicy poziomu satysfakcji pomiędzy porównywanymi kategoriami wykształcenia. Przeprowadzona analiza POST-HOC Dunna z korektą Bonferroniego wskazuje, że istotne różnice dotyczą osób z wykształceniem podstawowym i średnim oraz z wykształceniem podstawowym i wyższym. Nieco więcej różnic możemy potwierdzić wybierająć silniejszy POST-HOC Conover-Iman.

świadczy o istotnej różnicy poziomu satysfakcji pomiędzy porównywanymi kategoriami wykształcenia. Przeprowadzona analiza POST-HOC Dunna z korektą Bonferroniego wskazuje, że istotne różnice dotyczą osób z wykształceniem podstawowym i średnim oraz z wykształceniem podstawowym i wyższym. Nieco więcej różnic możemy potwierdzić wybierająć silniejszy POST-HOC Conover-Iman.

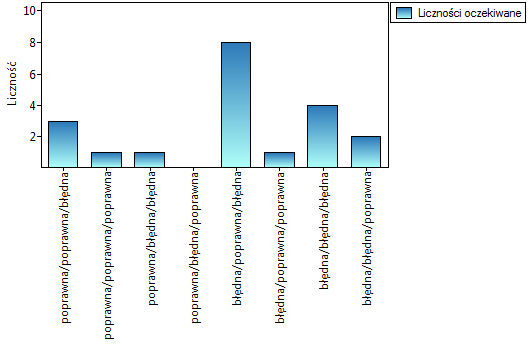

Na wykresie przedstawiającym mediany i kwartyle możemy zobaczyć grupy jednorodne wyznaczone przez test POST-HOC. Jeśli zdecydujemy się na przedstawienie wyników Dunna z korektą Bonferroniego zobaczymy dwie grupy jednorodne, które nie są zupełnie odrębne, tzn. grupę (a) - osoby słabiej oceniające satysfakcję z pracy i grupę (b)- osoby lepiej oceniające tę satysfakcję. Wykształcenie zawodowe przynależy do obydwu tych grup, co oznacza, że osoby z tym wykształceniem oceniają satysfakcję z pracy dość różnorodnie. Ten sam opis grup jednorodnych możemy znaleźć w wynikach testów POST-HOC.

Dokładny opis danych możemy przedstawić wybierając w oknie analizy statystyki opisowe  i wskazując na dodanie do opisu liczności i procentów.

i wskazując na dodanie do opisu liczności i procentów.

Rozkład odpowiedzi możemy też przedstawić na wykresie liczności.

2014/08/22 20:00

Test Jonckheere-Terpstra dla trendu

Test Jonckheere-Terpstra dla trendu (ang. the Jonckheere-Terpstra test for ordered alternatives) opisany niezależnie przez Jonckheere (1954) 18) i Terpstra (1952)19) może być wyliczany w takiej samej sytuacji jak ANOVA Kruskala-Wallisa, gdyż bazuje na tych samych założeniach. Test Jonckheere-Terpstra inaczej jednak ujmuje hipotezę alternatywną - wskazując w niej na istnienie trendu dla kolejnych populacji.

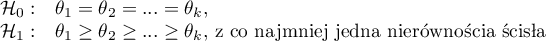

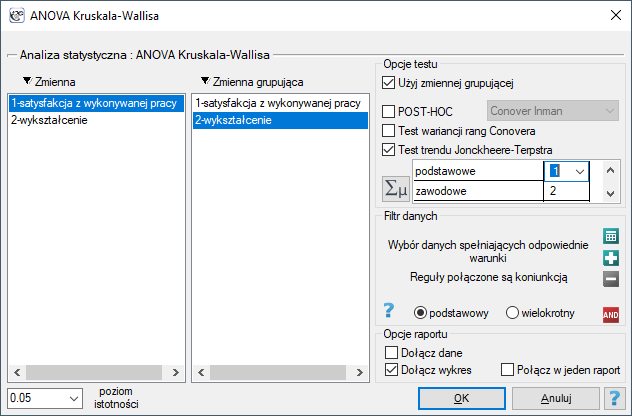

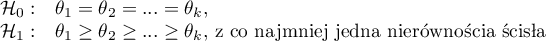

Hipotezy są upraszczane do median:

Uwaga!

Określenie: „z co najmniej jedną nierównością ścisłą” zapisane w hipotezie alternatywnej tego testu oznacza, że co najmniej mediana jednej populacji powinna być większa niż mediana innej populacji w kolejności określonej.

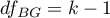

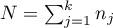

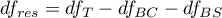

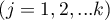

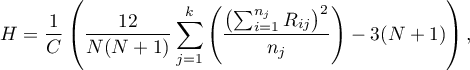

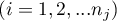

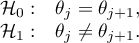

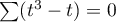

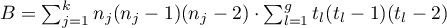

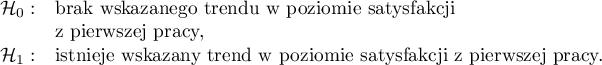

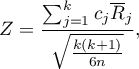

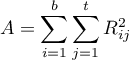

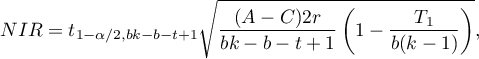

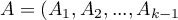

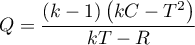

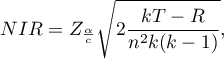

Statystyka testowa ma postać:

![LaTeX \begin{displaymath}

Z=\frac{L-\left[\frac{N^2-\sum_{j=1}^kn_j^2}{4}\right]}{SE}

\end{displaymath}](/lib/exe/fetch.php?media=wiki:latex:/img90c514ede7a37557872f285e3a796486.png)

gdzie:

- suma wartości

- suma wartości  uzyskanych dla każdej pary porównywanych populacji,

uzyskanych dla każdej pary porównywanych populacji,

- liczba wyników wyższych niż zadana wartość w grupie występującej w następnej kolejności,

- liczba wyników wyższych niż zadana wartość w grupie występującej w następnej kolejności,

,

,

,

,

,

,

,

,

- liczba grup różnych rang wiązanych,

- liczba grup różnych rang wiązanych,

-liczba przypadków wchodzących w skład rangi wiązanej,

-liczba przypadków wchodzących w skład rangi wiązanej,

,

,

- liczności prób dla

- liczności prób dla  .

.

Uwaga!

By można było przeprowadzić analizę trendu, należy wskazać oczekiwaną kolejność populacji przypisując im kolejne liczby naturalne.

Wzór na statystykę testową  zawiera poprawkę na rangi wiązane. Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych wzór na statystykę testową sprowadza się do oryginalnej formuły Jonckheere-Terpstra nie zawierającej tej poprawki).

zawiera poprawkę na rangi wiązane. Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych wzór na statystykę testową sprowadza się do oryginalnej formuły Jonckheere-Terpstra nie zawierającej tej poprawki).

Statystyka  ma asymptotycznie (dla dużych liczności) rozkład normalny.

ma asymptotycznie (dla dużych liczności) rozkład normalny.

Przy znanym oczekiwanym kierunku trendu, hipoteza alternatywna jest jednostronna i interpretacji podlega jednostronna wartość  . Interpretacja dwustronnej wartości

. Interpretacja dwustronnej wartości  oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość

oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Okno z ustawieniami opcji testu Jonckheere-Terpstra wywołujemy poprzez menu Statystyka→Testy nieparametryczne→ANOVA Kruskala-Wallisa lub poprzez Kreator.

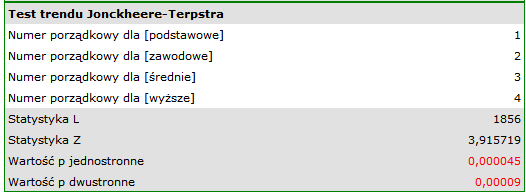

Pprzykład c.d. (plik satysfakcjaZpracy.pqs)

Podejrzewa się, że osoby lepiej wykształcone mają wysokie wymagania zawodowe, co może zmniejszać poziom satysfakcji z pierwszej pracy, która często takich wymagań nie spełnia. Dlatego też warto przeprowadzić analizę trendu.

Hipotezy:

W tym celu wznawiamy analizę przyciskiem  , zaznaczamy opcję

, zaznaczamy opcję Test trendu Jonckheere-Terpstra i kolejnym kategoriom wykształcenia przypisujemy kolejne liczby naturalne.

Uzyskana jednostronna wartość  i jest mniejsza niż zadany poziom istotności

i jest mniejsza niż zadany poziom istotności  , co przemawia na rzecz rzeczywiście występującego trendu zgodnego z oczekiwaniami badacza.

, co przemawia na rzecz rzeczywiście występującego trendu zgodnego z oczekiwaniami badacza.

Istnienie tego trendu możemy również potwierdzić przedstawiając procentowy rozkład uzyskanych odpowiedzi.

2014/12/18 19:10

· admin

Test wariancji rang Conover

Test kwadratów rang Conovera służy, podobnie jak test Fishera-Snedecora (dla  ), test Levene i test Browna-Forsythea (dla

), test Levene i test Browna-Forsythea (dla  ) do weryfikacji hipotezy podobnym zróżnicowaniu badanej zmiennej w kilku populacjach. Jest on nieparametrycznym odpowiednikiem wskazanych wyżej testów, przez to nie zakłada normalności rozkładu danych i opiera się na rangach 20). Jednak test ten bada zróżnicowanie, a więc odległości do średniej, dlatego podstawowym warunkiem jego stosowania jest:

) do weryfikacji hipotezy podobnym zróżnicowaniu badanej zmiennej w kilku populacjach. Jest on nieparametrycznym odpowiednikiem wskazanych wyżej testów, przez to nie zakłada normalności rozkładu danych i opiera się na rangach 20). Jednak test ten bada zróżnicowanie, a więc odległości do średniej, dlatego podstawowym warunkiem jego stosowania jest:

- pomiar na skali interwałowej,

Hipotezy:

Statystyka testowa ma postać:

gdzie:

,

,

- liczność w poszczególnych grupach,

- liczność w poszczególnych grupach,

- suma kwadratów rang w

- suma kwadratów rang w  -tej grupie,

-tej grupie,

- średnia wszystkich kwadratów rang,

- średnia wszystkich kwadratów rang,

,

,

-rangi dla wartości przedstawiających odległość pomiaru od średniej danej grupy.

-rangi dla wartości przedstawiających odległość pomiaru od średniej danej grupy.

Statystyka ta ma rozkład chi-kwadrat z  stopniem swobody.

stopniem swobody.

wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Okno z ustawieniami opcji testu wariancji rang Conovera wywołujemy poprzez menu Statystyka→Testy nieparametryczne→ANOVA Kruskala-Wallisa, opcja testu wariancji rang Conovera lub Statystyka→Testy nieparametryczne→Mann-Whitney, opcja testu wariancji rang Conovera.

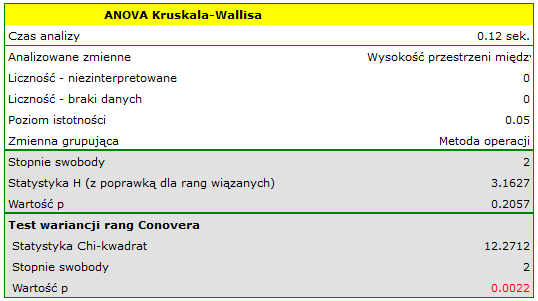

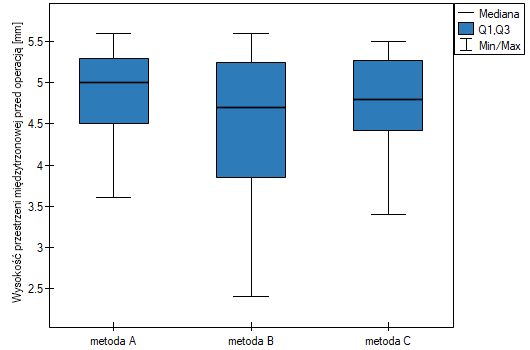

Przygotowano chorych do operacji kręgosłupa. Chorzy będą operowani jedną z trzech metod. Dokonano wstępnego przydziału każdej osoby chorej do poszczególnych typów operacji. Na późniejszym etapie zamierzamy porównywać stan chorych po przebytych operacjach, dlatego zależy nam by grupy chorych były porównywalne. Powinny być podobne min. pod względem wysokości przestrzeni międzytrzonowej (WPMT) przed operacją. Podobieństwo powinno dotyczyć nie tylko wartości przeciętnych ale również zróżnicowania grup.

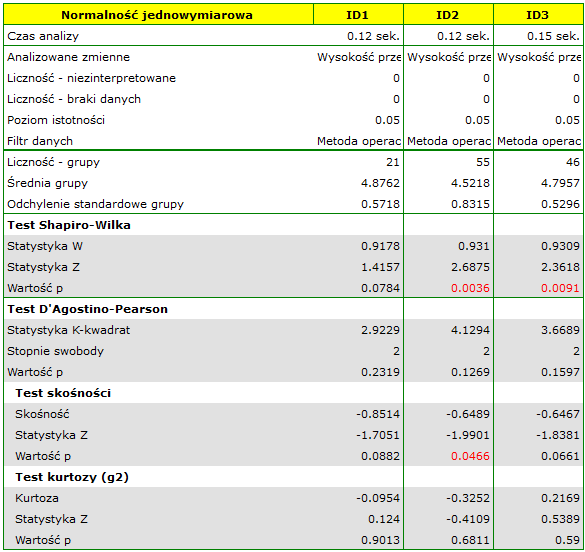

Sprawdzono rozkład danych.

Okazuje się, że w przypadku dwóch metod operacji WPMT wykazuje odstępstwa od normalności, których przyczyną w dużej mierze jest skośność danych. Dalsza analiza porównawcza przeprowadzona zostanie przy pomocy testu Kruskala-Wallisa, by porównać czy poziom WPMT różni się pomiędzy metodami oraz testu Conovera, który wskaże, czy w każdej metodzie rozpiętość wyników WPMT jest podobna.

Hipotezy dla testu wariancji Conovera:

Hipotezy dla testu Kruskala-Wallisa :

Najpierw interpretacji podlega wartość testu wariancji Conovera, która wskazuje na istotne statystycznie różnice w zakresach porównywanych grup (p=0.0022). Z wykresu możemy wnioskować, że różnice dotyczą głównie grupy 3. Ponieważ wykryto różnice w zakresie WPMT, to interpretacja wyniku testu Kruskala-Wallisa, porównującego poziom WPMT dla tych metod, powinna być ostrożna, gdyż test ten jest wrażliwy na niejednorodność wariancji. Mimo iż test Kruskala-Wallisa nie wykazał istotnych różnic (p=0.2057), to zaleca się by chorych o niskich WPMT (którzy zostali przypisani głównie do operacji metodą B) rozmieścić bardziej równomiernie tzn. by sprawdzić, czy nie można im zaproponować wykonania operacji metodą A lub C. Po ponownym przydziale chorych należy powtórzyć analizę.}

2021/01/11 21:38

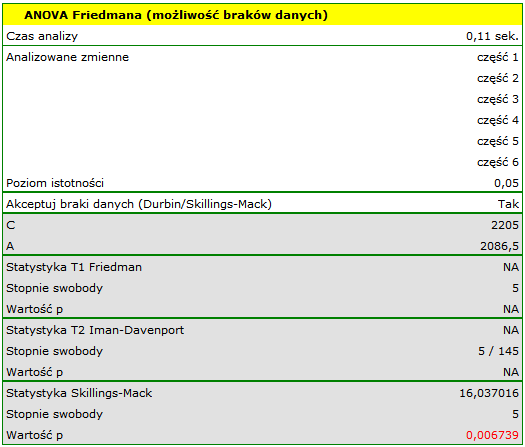

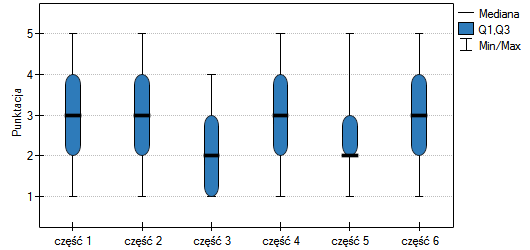

ANOVA Friedmana

Analiza wariancji powtarzanych pomiarów dla rang Friedmana, czyli ANOVA Friedmana (ang. Friedman repeated measures analysis of variance by ranks) opisana została przez Friedmana (1937)21). Test ten stosuje się w sytuacji, gdy pomiarów badanej zmiennej dokonujemy kilkukrotnie ( ) w różnych warunkach. Stosowana jest również, gdy dysponujemy rankingami pochodzącymi z różnych źródeł (od różnych sędziów) i dotyczącymi kilku (

) w różnych warunkach. Stosowana jest również, gdy dysponujemy rankingami pochodzącymi z różnych źródeł (od różnych sędziów) i dotyczącymi kilku ( ) obiektów a zależy nam na ocenie zgodności tych rankingów.

) obiektów a zależy nam na ocenie zgodności tych rankingów.

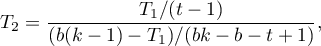

Iman Davenport (198022)) pokazał, że w wielu przypadkach statystka Friedmana jest nadmiernie konserwatywna i dokonał pewnej jej modyfikacji. Modyfikacja ta jest nieparametrycznym odpowiednikiem ANOVA powtarzanych pomiarów co sprawia, że jest obecnie rekomendowana do stosowania w zastępstwie tradycyjnej statystyki Friedmana.

Dodatkowe analizy:

- możliwe jest uwzględnienie braków danych poprzez opcje

Akceptuj braki danych, wyliczając ANOVA Durbina lub ANOVA Skillings-Mack; - możliwe jest testowanie trendu w ułożeniu badanych grup poprzez wykonanie testu Page dla trendu.

Podstawowe warunki stosowania:

- pomiar na skali porządkowej lub interwałowej,

Hipotezy dotyczą równości sumy rang dla kolejnych pomiarów lub są upraszczane do median:

gdzie:

mediany badanej cechy w kolejnych pomiarach z badanej populacji.

mediany badanej cechy w kolejnych pomiarach z badanej populacji.

Wyznacza się dwie statystyki testowe: statystykę Friedmana i modyfikację Imana-Davenport tej statystyki.

Statystyka Friedmana ma postać:

gdzie:

liczność próby,

liczność próby,

rangi przypisane kolejnym pomiarom

rangi przypisane kolejnym pomiarom  , oddzielnie dla każdego z badanych obiektów

, oddzielnie dla każdego z badanych obiektów  ,

,

korekta na rangi wiązane,

korekta na rangi wiązane,

liczba przypadków wchodzących w skład rangi wiązanej.

liczba przypadków wchodzących w skład rangi wiązanej.

Modyfikacjia Imana-Davenport statystyki Friedmana ma postać:

Wzór na statystykę  i

i  zawiera poprawkę na rangi wiązane

zawiera poprawkę na rangi wiązane  . Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych poprawka ta nie jest wyliczana, gdyż wówczas

. Poprawka ta jest stosowana, gdy rangi wiązane występują (gdy nie ma rang wiązanych poprawka ta nie jest wyliczana, gdyż wówczas  ).

).

Statystyka  ma asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z

ma asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z  stopniami swobody.

stopniami swobody.

Statystyka  podlega rozkładowi F Snedecora z

podlega rozkładowi F Snedecora z  i

i  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Testy POST-HOC

Wprowadzenie do kontrastów i testów POST-HOC przeprowadzone zostało w rozdziale dotyczącym jednoczynnikowej analizy wariancji.

Stosowany dla porównań prostych (liczność w poszczególnych pomiarach zawsze jest taka sama).

Test Dunna (Dunn 196423)) jest testem korygowanym ze względu na wielokrotne testowanie. Najczęściej wykorzystuje się tu korektę Bonferroniego lub Sidaka, chociaż dostępne są również inne, nowsze korekty opisane szerzej w dziale Wielokrotne porównania.

Przykład - porównania proste (porównanie pomiędzy sobą 2 wybranych median / średnich rang):

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu normalnego dla poziomu istotności

- to wartość krytyczna (statystyka) rozkładu normalnego dla poziomu istotności  skorygowanego o liczbę możliwych porównań prostych

skorygowanego o liczbę możliwych porównań prostych  zgodnie z wybraną poprawką.

zgodnie z wybraną poprawką.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

gdzie:

średnia rang

średnia rang  -tego pomiaru, dla

-tego pomiaru, dla  ,

,

Statystyka ta ma asymptotycznie (dla dużych liczności próby) rozkład normalny, a wartość p jest korygowana o liczbę możliwych porównań prostych zgodnie z wybraną poprawką.

Nieparametryczny odpowiednik LSD Fishera24), stosowany dla porównań prostych (liczność w poszczególnych pomiarach zawsze jest taka sama).

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

suma kwadratów dla rang,

suma kwadratów dla rang,

to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności

to wartość krytyczna (statystyka) rozkładu F Snedecora dla zadanego poziomu istotności  oraz dla stopni swobody odpowiednio: 1 i

oraz dla stopni swobody odpowiednio: 1 i  .

.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

gdzie:

- suma rang

- suma rang  -tego pomiaru, dla

-tego pomiaru, dla  ,

,

Statystyka ta podlega rozkładowi t-Studenta z  stopniami swobody.

stopniami swobody.

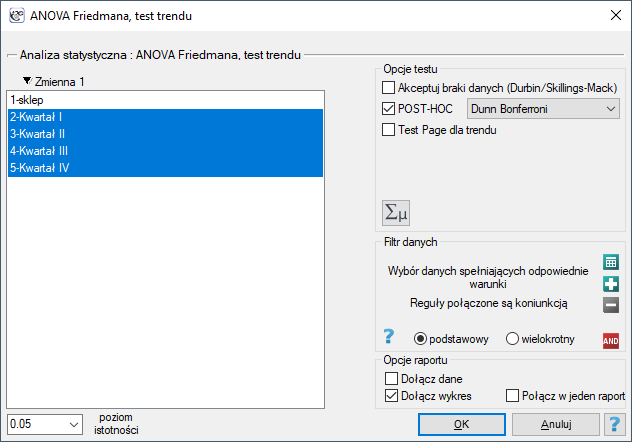

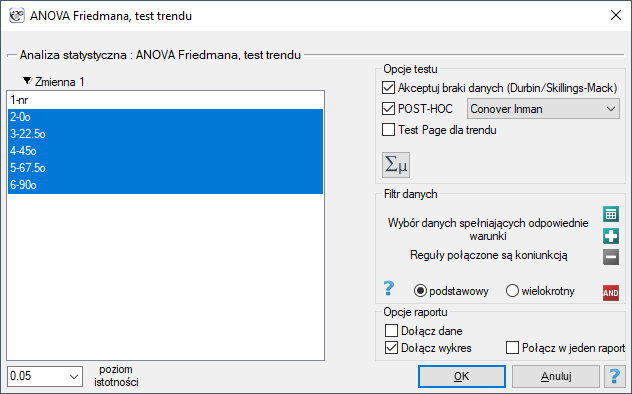

Okno z ustawieniami opcji ANOVA Friedmana wywołujemy poprzez menu Statystyka→Testy nieparametryczne→ANOVA Friedmana (możliwość braków danych) lub poprzez Kreator.

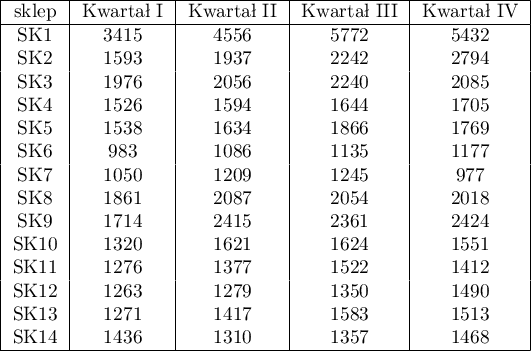

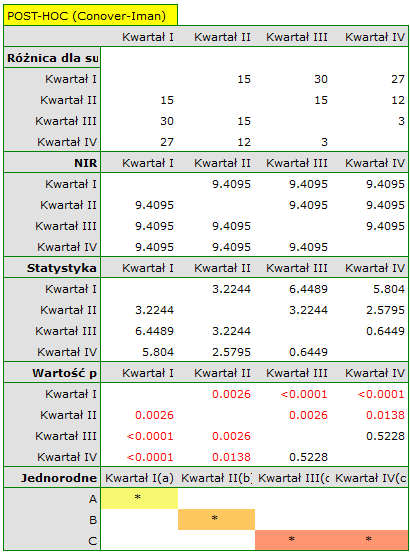

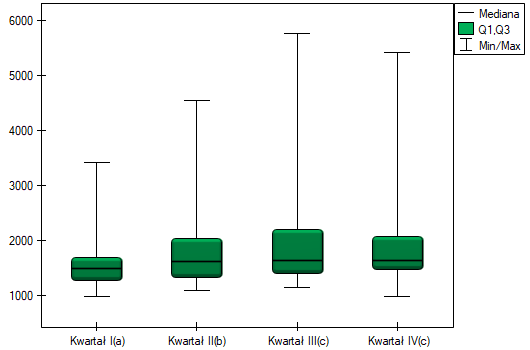

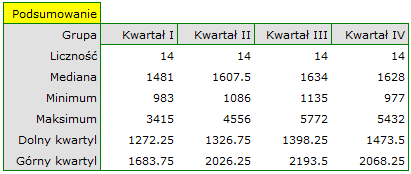

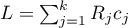

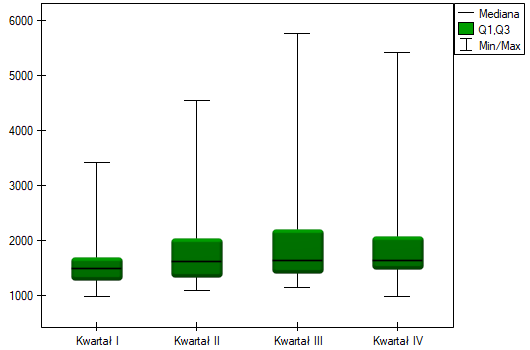

Badano kwartalną wielkość sprzedaży pewnego batonu czekoladowego w 14 losowo wybranych marketach. Badanie rozpoczęto w styczniu a zakończono w grudniu. W czasie drugiego kwartału trwała intensywna billboardowa kampania reklamowa tego produktu. Sprawdzimy, czy kampania miała wpływ na wielkość sprzedaży reklamowanego batonu.

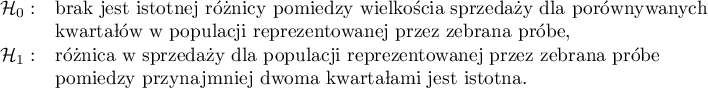

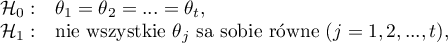

Hipotezy:

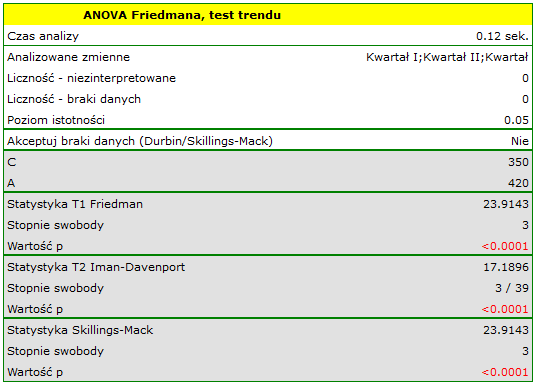

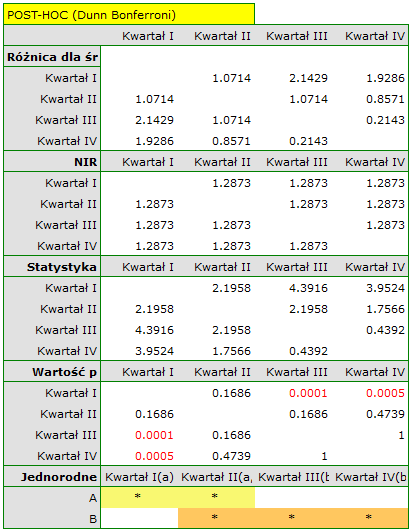

Porównując wartość p testu Friedmana (jak i wartość p korekty Iman-Davenport testu Friedmana) z poziomem istotności  , stwierdzamy, że sprzedaż batonu nie jest taka sama w każdym kwartale. Wykonana analiza POST-HOC Dunna z korektą Bonferroniego wskazuje na różnice wielkości sprzedaży dotyczące kwartału I i III oraz I i IV, a analogiczna analiza przeprowadzona silniejszym testem Conover-Iman wskazuje na różnice pomiędzy wszystkimi kwartałami za wyjątkiem kwartału III i IV.

, stwierdzamy, że sprzedaż batonu nie jest taka sama w każdym kwartale. Wykonana analiza POST-HOC Dunna z korektą Bonferroniego wskazuje na różnice wielkości sprzedaży dotyczące kwartału I i III oraz I i IV, a analogiczna analiza przeprowadzona silniejszym testem Conover-Iman wskazuje na różnice pomiędzy wszystkimi kwartałami za wyjątkiem kwartału III i IV.

Na wykresie przedstawiliśmy grupy jednorodne wyznaczone testem Conover-Iman.

Dokładny opis danych możemy przedstawić wybierając w oknie analizy statystyki opisowe  .

.

Gdyby dane były opisane skalą porzadkową o niewielu kategoriach, warto by było przedstawić je rownież w licznościach i procentach. W naszym przykładzie nie byłaby to dobra metoda opisu.

2014/08/22 20:00

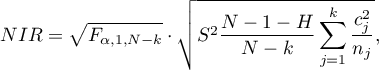

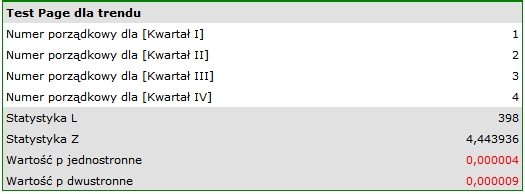

Test Page dla trendu

Test Page dla trendu (ang. the Page test for ordered alternative) opisany w roku 1963 przez Page E. B. 25) może być wyliczany w takiej samej sytuacji jak ANOVA Friedmana, gdyż bazuje na tych samych założeniach. Test Page inaczej jednak ujmuje hipotezę alternatywną - wskazując w niej na istnienie trendu w kolejnych pomiarach.

Hipotezy dotyczą równości sumy rang dla kolejnych pomiarów lub są upraszczane do median:

Uwaga!

Określenie: „z co najmniej jedną nierównością ścisłą” zapisane w hipotezie alternatywnej tego testu oznacza, że co najmniej jedna mediana powinna być większa niż mediana innej grupy pomiarów w kolejności określonej.

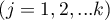

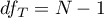

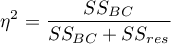

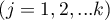

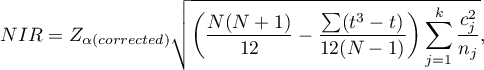

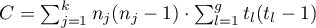

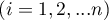

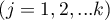

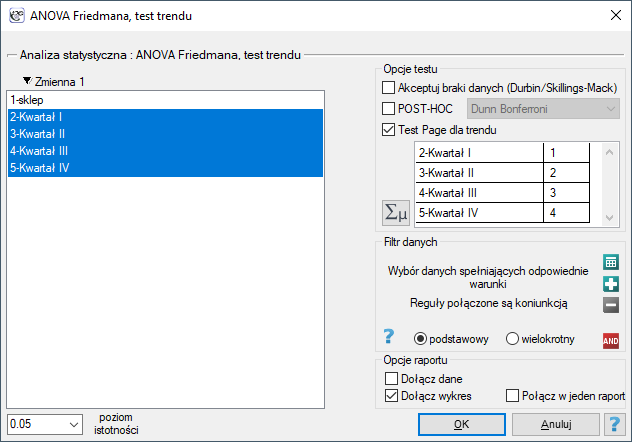

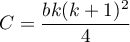

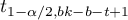

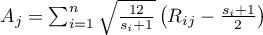

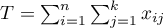

Statystyka testowa ma postać:

![LaTeX \begin{displaymath}

Z=\frac{L-\left[\frac{nk(k+1)^2}{4}\right]}{\sqrt{\frac{n(k^3-k)^2}{144(k-1)}}}

\end{displaymath}](/lib/exe/fetch.php?media=wiki:latex:/imgd8f373e9725654f26c78c01931a87148.png)

gdzie:

,

,

suma rang

suma rang  -tego pomiaru,

-tego pomiaru,

waga dla

waga dla  -tego pomiaru informująca o naturalnym porządku tego pomiaru w śród innych pomiarów (wagi to kolejne liczby naturalne).

-tego pomiaru informująca o naturalnym porządku tego pomiaru w śród innych pomiarów (wagi to kolejne liczby naturalne).

Uwaga!

By można było przeprowadzić analizę trendu, należy wskazać oczekiwane uporządkowanie pomiarów przypisując kolejne liczby naturalne kolejnym grupom pomiarowym. Liczby te w analizie traktowane są jako wagi  ,

,  , …,

, …,  .

.

Wzór na statystykę testową  nie zawiera poprawki na rangi wiązane, przez co staje się nieco bardziej konserwatywny, gdy rangi wiązane występują. Jednakże stosowanie korekty na rangi wiązane w przypadku tego testu nie jest rekomendowane.

nie zawiera poprawki na rangi wiązane, przez co staje się nieco bardziej konserwatywny, gdy rangi wiązane występują. Jednakże stosowanie korekty na rangi wiązane w przypadku tego testu nie jest rekomendowane.

Statystyka  ma asymptotycznie (dla dużych liczności) rozkład normalny.

ma asymptotycznie (dla dużych liczności) rozkład normalny.

Przy znanym oczekiwanym kierunku trendu, hipoteza alternatywna jest jednostronna i interpretacji podlega jednostronna wartość  . Interpretacja dwustronnej wartości

. Interpretacja dwustronnej wartości  oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość

oznacza, że badacz nie zna (nie zakłada) kierunku ewentualnego trendu. Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Okno z ustawieniami opcji testu Page wywołujemy poprzez menu Statystyka→Testy nieparametryczne→ANOVA Friedmana (możliwość braków danych) lub poprzez Kreator.

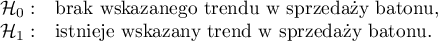

Przykład c.d. (plik baton.pqs)

Oczekiwanym skutkiem prowadzenia przez firmę intensywnej kampanii reklamowej jest stały wzrost sprzedaży oferowanego batonu.

Hipotezy:

Porównując jednostronną wartość  z poziomem istotności

z poziomem istotności  , stwierdzamy, że kampania przyniosła oczekiwany trend wzrostu sprzedaży produktu.

, stwierdzamy, że kampania przyniosła oczekiwany trend wzrostu sprzedaży produktu.

2014/12/18 22:10

· admin

ANOVA Durbina (brakujących danych)

Analiza wariancji powtarzanych pomiarów dla rang Durbina została zaproponowana przez Durbina (1951)26). Test ten stosuje się w sytuacji, gdy pomiarów badanej zmiennej dokonujemy kilkukrotnie - czyli w podobnej sytuacji w jakiej stosowana jest ANOVA Friedmana. Oryginalny test Durbina i test Friedmana dają ten sam wynik w sytuacji, gdy dysponujemy kompletnym zestawem danych. Test Durbina ma jednak pewną przewagę - można go również wyliczać dla niekompletnego zestawu danych. Przy czym braki danych nie mogą być zlokalizowane dowolnie, ale dane muszą tworzyć tzw. zbalansowany i niekompletny blok, czyli:

- liczba pomiarów dla każdego obiektu wynosi

(

( ),

), - każdy pomiar dokonywany jest na

obiektach (

obiektach ( ),

), - liczba obiektów dla których wykonano jednocześnie tą sama parę pomiarów jest stała i wynosi

.

.

gdzie:

- łączna liczba rozpatrywanych pomiarów,

- łączna liczba rozpatrywanych pomiarów,

- łączna liczba badanych obiektów

- łączna liczba badanych obiektów

Podstawowe warunki stosowania:

- pomiar na skali porządkowej lub interwałowej,

Hipotezy dotyczą równości sumy rang dla kolejnych pomiarów ( ) lub są upraszczane do median (

) lub są upraszczane do median ( ):

):

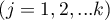

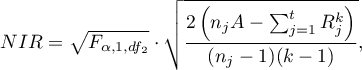

Wyznacza się dwie statystyki testowe o następującej postaci:

![LaTeX \begin{displaymath}

T_1=\frac{(t-1)\left[\sum_{j=1}^tR_j^2-tC\right]}{A-C},

\end{displaymath}](/lib/exe/fetch.php?media=wiki:latex:/img6263bdbeddade6aabd733985ed7a7916.png)

gdzie:

- suma rang dla kolejnych pomiarów

- suma rang dla kolejnych pomiarów  ,

,

- rangi przypisane kolejnym pomiarom, oddzielnie dla każdego z badanych obiektów

- rangi przypisane kolejnym pomiarom, oddzielnie dla każdego z badanych obiektów  ,

,

suma kwadratów dla rang,

suma kwadratów dla rang,

współczynnik korekcji.

współczynnik korekcji.

Wzór na statystykę  i

i  zawiera poprawkę na rangi wiązane.

zawiera poprawkę na rangi wiązane.

W przypadku danych kompletnych statystyka  jest tożsama z testem Friedmana. Ma ona asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z

jest tożsama z testem Friedmana. Ma ona asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z  stopniami swobody.

stopniami swobody.

Statystyka  to odpowiednik korekty Iman-Davenport ANOVA Friedmana, więc podlega rozkładowi F Snedecora z

to odpowiednik korekty Iman-Davenport ANOVA Friedmana, więc podlega rozkładowi F Snedecora z  i

i  stopniami swobody. Uznaje się ją obecnie za bardziej precyzyjną niż statystykę

stopniami swobody. Uznaje się ją obecnie za bardziej precyzyjną niż statystykę  i rekomenduje jej stosowanie27).

i rekomenduje jej stosowanie27).

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Testy POST-HOC

Wprowadzenie do kontrastów i testów POST-HOC przeprowadzone zostało w rozdziale dotyczącym jednoczynnikowej analizy wariancji.

Stosowany dla porównań prostych (liczność w poszczególnych pomiarach zawsze jest taka sama).

Hipotezy:

Przykład - porównania proste (porównanie pomiędzy sobą 2 wybranych median / sum rang):

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

Wartość najmniejszej istotnej różnicy wyliczana jest z wzoru:

gdzie:

- to wartość krytyczna (statystyka) rozkładu t-Studenta dla poziomu istotności

- to wartość krytyczna (statystyka) rozkładu t-Studenta dla poziomu istotności  i

i  stopni swobody.

stopni swobody.

Statystyka testowa ma postać:

Statystyka testowa ma postać:

Statystyka ta podlega rozkładowi t-Studenta z  stopniami swobody.

stopniami swobody.

Okno z ustawieniami opcji ANOVA Durbina wywołujemy poprzez menu Statystyka→Testy nieparametryczne→ANOVA Friedmana (możliwość braków danych) lub poprzez Kreator.

Uwaga!

By rekordy w których występują braki danych były brane pod uwagę wymagane jest zaznaczenie opcji Akceptuj braki danych. Jako braki danych traktowane są puste komórki oraz komórki o wartościach nieliczbowych. W analizie biorą udział tylko rekordy zawierające więcej niż jedną wartość liczbową.

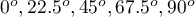

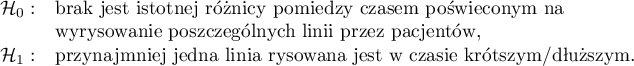

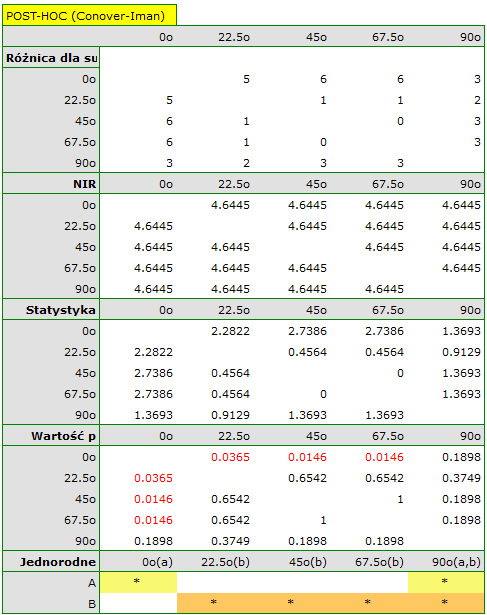

Przeprowadzono eksperyment wśród 20 pacjentów szpitala psychiatrycznego (Ogilvie 1965 28)). Eksperyment ten polegał na odrysowaniu linii prostych według zaprezentowanego wzoru. Wzór przedstawiał 5 linii rysowanych pod różnym kątem ( ) względem wskazanego środka. Zadaniem pacjentów było odwzorowanie linii mając zasłoniętą dłoń. Jako wynik eksperymentu zapisano czas w jakim pacjent kreślił daną linię. W idealnym przypadku każdy pacjent kreśliłby linię pod każdym kątem, jednak upływający czas i zmęczenie miałyby znaczny wpływ na wydajność pracy. Ponadto trudno jest utrzymać zainteresowanie pacjenta i chęć współpracy przez dłuższy czas. W związku z tym projekt zaplanowano i przeprowadzono w zbalansowanych i niekompletnych blokach. Każdy z 20 pacjentów wyrysowywał linię pod dwoma kontami (możliwych kątów było pięć). W ten sposób każdy kąt wyrysowywany był ośmiokrotnie. Czas w jakim każdy pacjent wyrysowywał linię pod zadanym kątem zapisano w tabeli.

) względem wskazanego środka. Zadaniem pacjentów było odwzorowanie linii mając zasłoniętą dłoń. Jako wynik eksperymentu zapisano czas w jakim pacjent kreślił daną linię. W idealnym przypadku każdy pacjent kreśliłby linię pod każdym kątem, jednak upływający czas i zmęczenie miałyby znaczny wpływ na wydajność pracy. Ponadto trudno jest utrzymać zainteresowanie pacjenta i chęć współpracy przez dłuższy czas. W związku z tym projekt zaplanowano i przeprowadzono w zbalansowanych i niekompletnych blokach. Każdy z 20 pacjentów wyrysowywał linię pod dwoma kontami (możliwych kątów było pięć). W ten sposób każdy kąt wyrysowywany był ośmiokrotnie. Czas w jakim każdy pacjent wyrysowywał linię pod zadanym kątem zapisano w tabeli.

Chcemy sprawdzić, czy czas jaki został poświęcony na wyrysowanie poszczególnych linii jest zupełnie losowy, czy też są linie, których wyrysowywanie zajęło więcej lub mniej czasu.

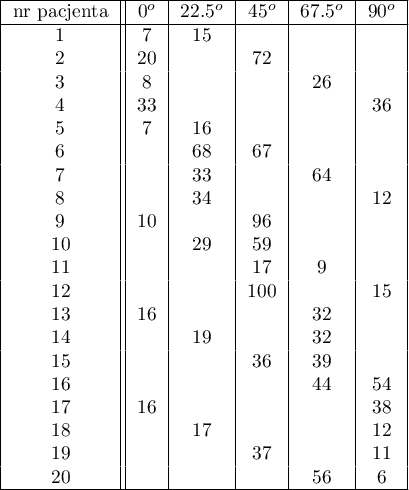

Hipotezy:

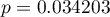

Porównując wartość  dla statystyki

dla statystyki  (lub wartość

(lub wartość  dla statystyki

dla statystyki  ) z poziomem istotności

) z poziomem istotności  stwierdzamy, że linie nie są rysowane w tym samym czasie. Wykonana analiza POST-HOC wskazuje na różnice czasu poświęconego na narysowanie linii pod kątem

stwierdzamy, że linie nie są rysowane w tym samym czasie. Wykonana analiza POST-HOC wskazuje na różnice czasu poświęconego na narysowanie linii pod kątem  . Jest ona rysowana szybciej niż linie pod kątem

. Jest ona rysowana szybciej niż linie pod kątem  ,

,  oraz

oraz  .

.

Na wykresie zaznaczono grupy jednorodne wskazane przez test post-hoc.

2014/12/18 22:18

· admin

ANOVA Skillings-Mack (brakujących danych)

Analiza wariancji powtarzanych pomiarów dla rang Skillings-Mack została zaproponowana przez Skillings'a i Mack'a w roku 1981 29). Jest to test, który może być wykorzystywany w przypadku występowania braków danych, ale braki te nie muszą występować w żadnym szczególnym układzie. Każdy obiekt musi mieć jednak przynajmniej dwie obserwacje. Jeśli nie ma rang wiązanych a braki nie występują jest tożsamy z ANOVA Friedmana, a jeśli braki danych występują w układzie zbalansowanym odpowiada wynikom ANOVA Durbina.

Podstawowe warunki stosowania:

- pomiar na skali porządkowej lub interwałowej,

Hipotezy dotyczą równości sumy rang dla kolejnych pomiarów ( ) lub są upraszczane do median (

) lub są upraszczane do median ( ):

):

Statystyka testowa ma postać:

gdzie:

,

,

- liczba obserwacji dla

- liczba obserwacji dla  -tego obiektu,

-tego obiektu,

- rangi przypisane kolejnym pomiarom (

- rangi przypisane kolejnym pomiarom ( ), oddzielnie dla każdego z badanych obiektów (

), oddzielnie dla każdego z badanych obiektów ( ), przy czym rangi dla braków danych równe są średniej randze dla danego obiektu,

), przy czym rangi dla braków danych równe są średniej randze dla danego obiektu,

- macierz wyznaczająca kowariancje dla

- macierz wyznaczająca kowariancje dla  przy prawdziwości

przy prawdziwości  30).

30).

Gdy każda para pomiarów występuje równocześnie dla przynajmniej jednej obserwacji, statystyka ta ma asymptotycznie (dla dużych liczności) rozkład chi-kwadrat z  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

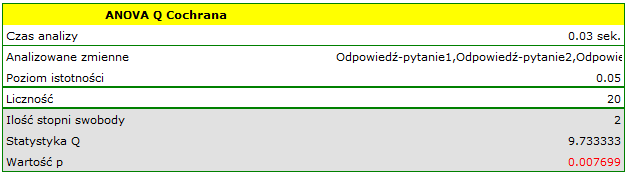

: