Spis treści

Testy parametryczne

Współczynniki korelacji liniowej

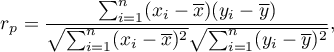

Współczynnik korelacji liniowej Pearsona  (ang. Pearson product-moment correlation coefficient, Pearson (1896,1900)) jest wykorzystywany do badania siły związku liniowego pomiędzy cechami. Można go wyznaczać dla skali interwałowej, o ile brak jest odstających pomiarów, a rozkład reszt lub badanych cech jest rozkładem normalnym.

(ang. Pearson product-moment correlation coefficient, Pearson (1896,1900)) jest wykorzystywany do badania siły związku liniowego pomiędzy cechami. Można go wyznaczać dla skali interwałowej, o ile brak jest odstających pomiarów, a rozkład reszt lub badanych cech jest rozkładem normalnym.

gdzie:

- kolejne wartości cechy

- kolejne wartości cechy  i

i  ,

,

- średnie z wartości cechy

- średnie z wartości cechy  i cechy

i cechy  ,

,

- liczność próby.

- liczność próby.

Uwaga!

oznacza współczynnik korelacji Pearsona populacji, natomiast

oznacza współczynnik korelacji Pearsona populacji, natomiast  w próbie.

w próbie.

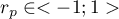

Wartość  interpretujemy w następujący sposób:

interpretujemy w następujący sposób:

oznacza silną dodatnią zależność liniową, tj. punkty pomiarowe leżą blisko linii prostej a wzrostowi zmiennej niezależnej odpowiada wzrost zmiennej zależnej;

oznacza silną dodatnią zależność liniową, tj. punkty pomiarowe leżą blisko linii prostej a wzrostowi zmiennej niezależnej odpowiada wzrost zmiennej zależnej; oznacza silną ujemną zależność liniową, tj. punkty pomiarowe leżą blisko linii prostej, lecz wzrostowi zmiennej niezależnej odpowiada spadek zmiennej zależnej;

oznacza silną ujemną zależność liniową, tj. punkty pomiarowe leżą blisko linii prostej, lecz wzrostowi zmiennej niezależnej odpowiada spadek zmiennej zależnej;- gdy współczynnik korelacji liniowej przyjmuje wartość równą lub bardzo bliską zeru wówczas nie istnieje liniowa zależność między badanymi parametrami (ale może istnieć związek nieliniowy).

Interpretacja graficzna współczynnika  .

.

Gdy jedna z badanych cech jest stała (niezależnie od zmian drugiej cechy) to nie są one związane zależnością. Współczynnika  nie można wyznaczyć.

nie można wyznaczyć.

Uwaga!

Błędem jest wyznaczanie współczynnika korelacji, gdy w próbie występują obserwacje odstające, które mogą całkowicie przekłamać wartość i znak współczynnika korelacji Pearsona, gdy próba jest wyraźnie niejednorodna, bądź też badana zależność wyraźnie przyjmuje kształt inny niż liniowy.

Współczynnik determinacji -  . Wyraża procent zmienności zmiennej zależnej tłumaczony zmiennością zmiennej niezależnej.

. Wyraża procent zmienności zmiennej zależnej tłumaczony zmiennością zmiennej niezależnej.

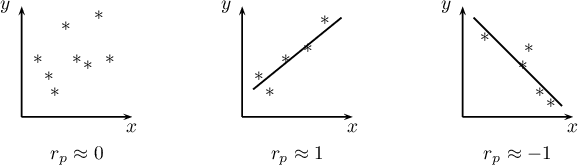

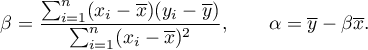

Tworzony model korelacji przedstawia zależność liniową postaci:

Współczynniki  i

i  równania regresji liniowej możemy wyznaczyć z wzorów:

równania regresji liniowej możemy wyznaczyć z wzorów:

Przykład c.d. (plik wiek-wzrost.pqs)

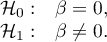

Istotność współczynnika korelacji Pearsona

Test t do sprawdzania istotności współczynnika korelacji liniowej Pearsona

Test do sprawdzania istotności współczynnika korelacji liniowej Pearsona (ang. test of significance for a Pearson product-moment correlation coefficient) służy do weryfikacji hipotezy o braku zależności liniowej pomiędzy badanymi cechami populacji i opiera się na współczynniku korelacji liniowej Pearsona wyliczonym dla próby. Im wartość współczynnika  jest bliższa 0, tym słabszą zależnością związane są badane cechy.

jest bliższa 0, tym słabszą zależnością związane są badane cechy.

Podstawowe warunki stosowania:

- pomiar na skali interwałowej,

- normalność rozkładu badanych cech w populacji lub normalność reszt modelu.

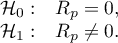

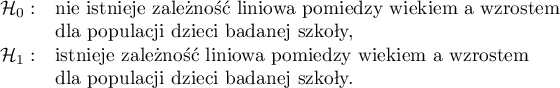

Hipotezy:

Statystyka testowa ma postać:

gdzie  .

.

Wartość statystyki testowej nie może być wyznaczona, gdy  lub

lub  albo, gdy

albo, gdy  .

.

Statystyka testowa ma rozkład t-Studenta z  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Przykład c.d. (plik wiek-wzrost.pqs)

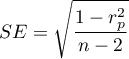

Istotność współczynnika nachylenia prostej

Test t do sprawdzania istotności współczynników równania regresji liniowej

Test ten służy do weryfikacji hipotezy o braku zależności liniowej pomiędzy badanymi cechami populacji i opiera się na współczynniku nachylenia prostej wyliczonym dla próby. Im wartość współczynnika  będzie bliższa 0, tym słabszą zależność dopasowana prosta przedstawia.

będzie bliższa 0, tym słabszą zależność dopasowana prosta przedstawia.

Podstawowe warunki stosowania:

- pomiar na skali interwałowej,

- normalność rozkładu badanych cech w populacji lub normalność reszt modelu.

Hipotezy:

Statystyka testowa ma postać:

gdzie:

,

,

,

,

- odchylenie standardowe wartości cechy

- odchylenie standardowe wartości cechy  i cechy

i cechy  .

.

Wartość statystyki testowej nie może być wyznaczona, gdy  lub

lub  albo, gdy

albo, gdy  .

.

Statystyka testowa ma rozkład t-Studenta z  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

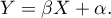

Predykcja

polega na przewidywaniu wartości jednej ze zmiennych (najczęściej zmiennej zależnej  ) na podstawie wartości innej zmiennej (najczęściej zmiennej niezależnej

) na podstawie wartości innej zmiennej (najczęściej zmiennej niezależnej  ). Dokładność wyznaczonej wartości określają obliczone dla niej przedziały predykcji.

). Dokładność wyznaczonej wartości określają obliczone dla niej przedziały predykcji.

- Interpolacja polega na przewidywaniu wartości zadanej zmiennej leżącej wewnątrz obszaru, dla którego wykonaliśmy model regresji. Interpolacja jest więc z reguły procedurą bezpieczną - zakłada się tu jedynie ciągłość funkcji wyrażającej zależność obu zmiennych.

- Ekstrapolacja polega na przewidywaniu wartości zadanej zmiennej leżącej poza obszarem, dla którego zbudowaliśmy model regresji. W przeciwieństwie do interpolacji, ekstrapolacja bywa często zabiegiem ryzykownym i dokonuje się jej jedynie w niewielkiej odległości od obszaru, dla którego powstał model regresji. Podobnie jak w interpolacji zakłada się ciągłość funkcji wyrażającej zależność obu zmiennych.

Analiza reszt modelu - wyjaśnienie w module Regresja Wieloraka.

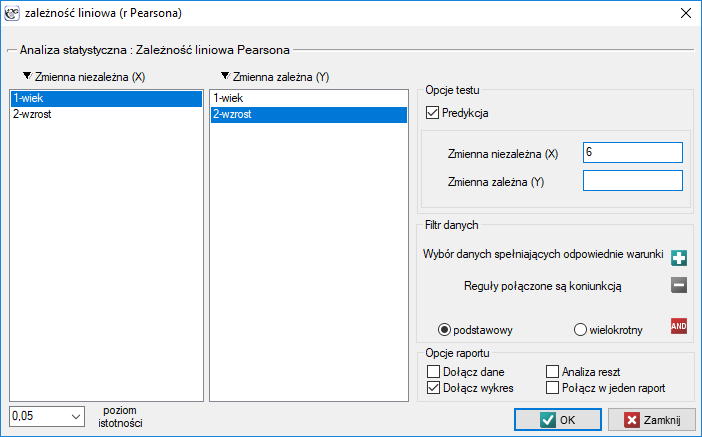

Okno z ustawieniami opcji zależności liniowej Pearsona wywołujemy poprzez menu Statystyka→Testy parametryczne→zależność liniowa (r-Pearsona) lub poprzez ''Kreator''.

Przykład (plik wiek-wzrost.pqs)

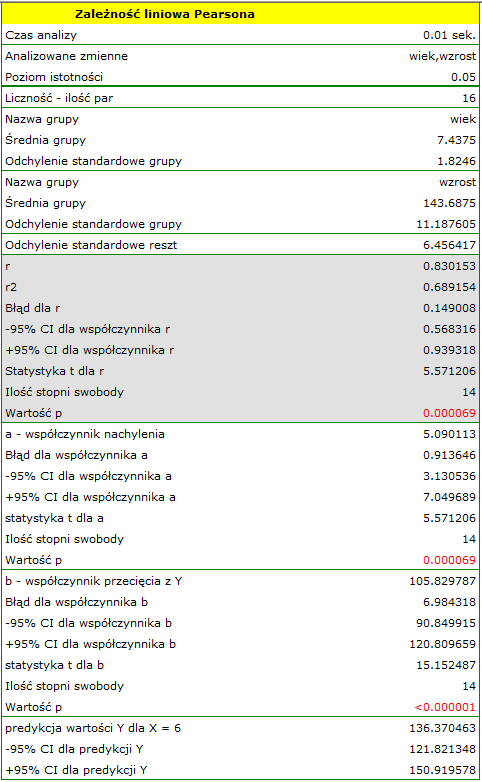

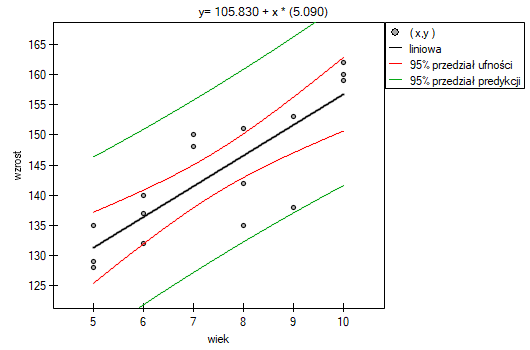

Wśród uczniów pewnej szkoły baletowej badano zależność pomiędzy wiekiem a wzrostem. W tym celu pobrano próbę obejmującą szesnaścioro dzieci i zapisano dla nich następujące wyniki pomiaru tych cech:

(wiek, wzrost): (5, 128) (5, 129) (5, 135) (6, 132) (6, 137) (6, 140) (7, 148) (7, 150) (8, 135) (8, 142) (8, 151) (9, 138) (9, 153) (10, 159) (10, 160) (10, 162).}

Hipotezy:

Porównując wartość  =0.000069 z poziomem istotności

=0.000069 z poziomem istotności  stwierdzamy, że istnieje zależność liniowa pomiędzy wiekiem a wzrostem dla populacji dzieci badanej szkoły. Zależność ta jest wprost proporcjonalna, tzn. wraz ze wzrostem wieku dzieci rośnie wysokość ciała.

stwierdzamy, że istnieje zależność liniowa pomiędzy wiekiem a wzrostem dla populacji dzieci badanej szkoły. Zależność ta jest wprost proporcjonalna, tzn. wraz ze wzrostem wieku dzieci rośnie wysokość ciała.

Współczynnik korelacji liniowej Pearsona, a zatem siła związku liniowego pomiędzy wiekiem a wzrostem wynosi  =0.8302. Współczynnik determinacji

=0.8302. Współczynnik determinacji  oznacza, że ok. 69% zmienności wzrostu jest tłumaczona zmiennością wieku.

oznacza, że ok. 69% zmienności wzrostu jest tłumaczona zmiennością wieku.

Z równania regresji postaci:

można wyliczyć predykcyjną wartość dla dziecka w wieku np. 6 lat. Przewidywany wzrost takiego dziecka wynosi 136.37cm.

można wyliczyć predykcyjną wartość dla dziecka w wieku np. 6 lat. Przewidywany wzrost takiego dziecka wynosi 136.37cm.

Porównanie współczynników korelacji

Test t do sprawdzania równości współczynników korelacji liniowej Pearsona pochodzących z 2 niezależnych populacji

Test ten służy do weryfikacji hipotezy o równości dwóch współczynników korelacji liniowej Pearsona ( ,

,  .

.

Podstawowe warunki stosowania:

- współczynniki

i

i  badają zależność tych samych cech

badają zależność tych samych cech  i

i  ,

, - znane są liczności obu prób

i

i  .

.

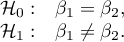

Hipotezy:

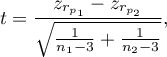

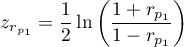

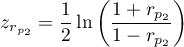

Statystyka testowa ma postać:

gdzie:

,

,

.

.

Statystyka testowa ma rozkład t-Studenta z  stopniami swobody.

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Uwaga! W podobny sposób można dokonać porównania współczynników nachylenia prostych regresji.

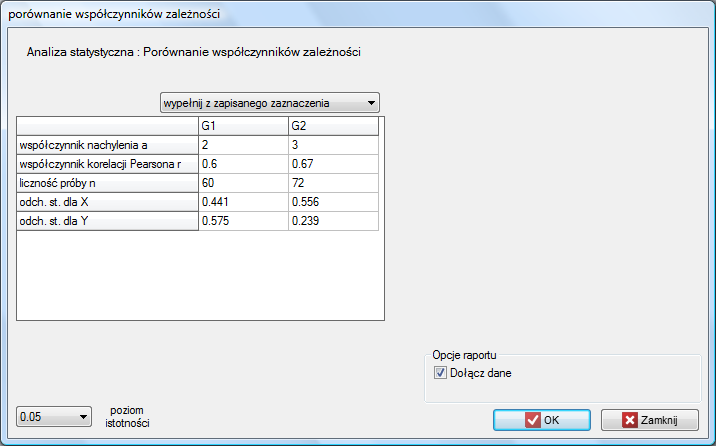

Porównanie nachylenia prostych regresji

Test t do sprawdzania równości współczynników regresji liniowej pochodzących z 2 niezależnych populacji

Test ten służy do weryfikacji hipotezy o równości dwóch współczynników regresji liniowej  i

i  w badanych populacjach.

w badanych populacjach.

Podstawowe warunki stosowania:

- współczynniki

i

i  badają zależność tych samych cech

badają zależność tych samych cech  i

i  ,

, - znane są liczności obu prób

i

i  ,

,

Hipotezy:

Statystyka testowa ma postać:

gdzie:

,

,

.

.

Statystyka testowa ma rozkład t-Studenta z  stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość

stopniami swobody.

Wyznaczoną na podstawie statystyki testowej wartość  porównujemy z poziomem istotności

porównujemy z poziomem istotności  :

:

Okno z ustawieniami opcji porównania współczynników zależności wywołujemy poprzez menu Statystyka→Testy parametryczne→porównanie współczynników zależności.

i

i  ,

,